आर्टिफिशियल इंटेलिजेंस (AI) हमारे जीवन का एक अभिन्न अंग बन चुका है, लेकिन अक्सर हम यह नहीं समझ पाते कि एक AI मॉडल कोई विशेष निर्णय कैसे लेता है। यहीं पर Explainable AI (XAI) का महत्व आता है। XAI का उद्देश्य इन ‘ब्लैक बॉक्स’ मॉडल्स को समझना, उनकी कार्यप्रणाली को Transparent बनाना है। यह न केवल AI पर हमारा विश्वास बढ़ाता है, बल्कि हमें यह भी समझने में मदद करता है कि मॉडल कब और क्यों गलतियाँ कर रहा है। इस लेख में, हम XAI के सबसे महत्वपूर्ण पहलुओं में से एक, Interpretability Techniques को गहराई से जानेंगे, जो हमें AI निर्णयों के पीछे की वजहों को समझने में मदद करती हैं। हम विभिन्न तरीकों और उनकी कार्यप्रणाली पर चर्चा करेंगे, जिससे आप AI मॉडल्स को और बेहतर तरीके से समझ पाएंगे।

Explainable AI (XAI) क्या है और इसकी ज़रूरत क्यों है?

आर्टिफिशियल इंटेलिजेंस, खासकर मशीन लर्निंग (Machine Learning) के Deep Learning मॉडल्स, अपनी जटिलता के कारण अक्सर ‘ब्लैक बॉक्स’ की तरह काम करते हैं। इसका मतलब है कि वे इनपुट लेते हैं और आउटपुट देते हैं, लेकिन यह समझना बहुत मुश्किल होता है कि उन्होंने वह विशेष आउटपुट कैसे जेनरेट किया। जब AI सिस्टम मेडिकल डायग्नोसिस, लोन अप्रूवल या कानूनी फैसलों जैसे महत्वपूर्ण क्षेत्रों में निर्णय लेते हैं, तो उनके निर्णयों की व्याख्या करना बहुत ज़रूरी हो जाता है।

यहीं पर Explainable AI (XAI) की भूमिका शुरू होती है। XAI एक ऐसा क्षेत्र है जो AI मॉडल्स को अधिक Transparent, Understandable और Interpretable बनाने पर केंद्रित है। इसकी मुख्य ज़रूरतें इस प्रकार हैं:

- विश्वास (Trust): यदि हम AI सिस्टम के निर्णयों को नहीं समझ सकते, तो उन पर पूरी तरह से भरोसा करना मुश्किल हो जाता है। व्याख्या क्षमता विश्वास बनाने में मदद करती है।

- जवाबदेही (Accountability): जब कोई AI सिस्टम गलती करता है, तो यह समझना ज़रूरी है कि गलती कहाँ हुई और क्यों हुई, ताकि उसे सुधारा जा सके।

- निष्पक्षता (Fairness) और पूर्वाग्रह (Bias) का पता लगाना: XAI हमें यह पहचानने में मदद करता है कि क्या कोई मॉडल किसी विशेष समूह के प्रति पक्षपाती (biased) है और इन पूर्वाग्रहों को कैसे दूर किया जाए।

- डीबगिंग और सुधार (Debugging and Improvement): मॉडल के खराब प्रदर्शन के कारणों को समझने से डेवलपर्स को मॉडल को बेहतर बनाने में मदद मिलती है।

- नियामक अनुपालन (Regulatory Compliance): कुछ उद्योगों में, AI निर्णयों की व्याख्या करने की कानूनी आवश्यकताएँ होती हैं (जैसे GDPR का ‘right to explanation’)।

संक्षेप में, XAI सिर्फ एक तकनीकी आवश्यकता नहीं है, बल्कि एक नैतिक और सामाजिक आवश्यकता भी है जो AI को अधिक प्रभावी और जिम्मेदार बनाती है।

Interpretability Techniques के प्रकार: White Box बनाम Black Box Models

Interpretability Techniques वे तरीके हैं जो हमें AI मॉडल के निर्णयों को समझने और उनकी व्याख्या करने में मदद करते हैं। इन्हें मुख्य रूप से दो श्रेणियों में बांटा जा सकता है, जो मॉडल की अंतर्निहित जटिलता पर आधारित होती हैं:

1. Inherently Interpretable (White Box) Models:

ये वे AI मॉडल्स हैं जिनकी कार्यप्रणाली स्वाभाविक रूप से सरल और समझने योग्य होती है। उनके निर्णय लेने की प्रक्रिया को सीधे देखा और समझा जा सकता है।

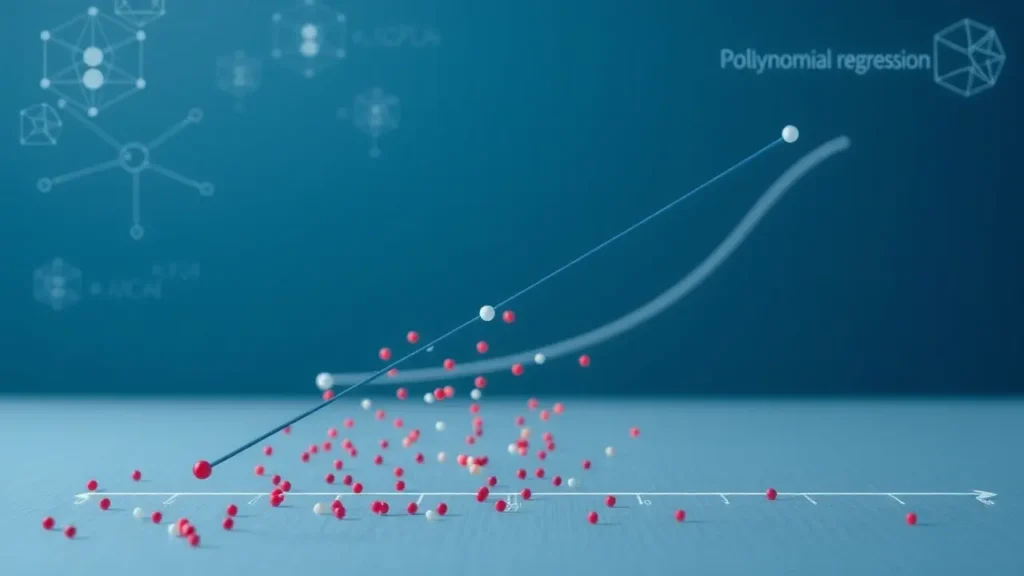

- Linear Regression: यह एक गणितीय समीकरण के माध्यम से इनपुट फीचर्स और आउटपुट के बीच सीधा संबंध दिखाता है। प्रत्येक फीचर का गुणांक (coefficient) यह बताता है कि उस फीचर में एक इकाई के बदलाव से आउटपुट में कितना बदलाव आएगा।

- Decision Trees: ये एक फ्लोचार्ट जैसे स्ट्रक्चर में निर्णय प्रक्रिया को दर्शाते हैं। आप आसानी से देख सकते हैं कि कौन से फीचर्स और किस थ्रेशोल्ड पर मॉडल एक विशेष निर्णय लेता है। प्रत्येक ‘नोड’ एक प्रश्न और ‘पत्ती’ (leaf) एक अंतिम निर्णय का प्रतिनिधित्व करती है।

- Rule-Based Systems: ये स्पष्ट “यदि-तो” (if-then) नियमों के सेट पर आधारित होते हैं, जिन्हें आसानी से समझा जा सकता है।

इन मॉडल्स में, व्याख्या अंतर्निहित (built-in) होती है, इसलिए किसी अतिरिक्त Interpretability Technique की आवश्यकता नहीं होती। हालांकि, ये मॉडल्स अक्सर बहुत जटिल डेटासेट पर Black Box मॉडल्स जितने सटीक नहीं होते।

2. Post-Hoc Interpretability for Black Box Models:

जब हम Deep Learning या Complex Ensemble Models (जैसे Random Forests या Gradient Boosting) जैसे Black Box मॉडल्स का उपयोग करते हैं, तो उनकी आंतरिक कार्यप्रणाली को सीधे समझना असंभव होता है। ऐसे में, हमें मॉडल के प्रशिक्षण के बाद (post-hoc) व्याख्या तकनीकें लागू करनी पड़ती हैं। ये तकनीकें मॉडल के व्यवहार का विश्लेषण करती हैं और यह समझने की कोशिश करती हैं कि उसने कोई विशेष निर्णय क्यों लिया।

इन तकनीकों को आगे Model-Specific (जो केवल एक विशेष प्रकार के मॉडल पर काम करती हैं) और Model-Agnostic (जो किसी भी मॉडल पर लागू हो सकती हैं) में वर्गीकृत किया जा सकता है। हमारा ध्यान मुख्य रूप से Model-Agnostic तकनीकों पर रहेगा क्योंकि वे अधिक व्यापक रूप से लागू होती हैं।

यह समझना महत्वपूर्ण है कि White Box मॉडल्स हमेशा Transparent होते हैं, जबकि Black Box मॉडल्स को Transparent बनाने के लिए हमें विशेष Interpretability Techniques का उपयोग करना पड़ता है।

Model-Agnostic Interpretability Techniques: LIME और SHAP

Model-Agnostic Interpretability Techniques वे शक्तिशाली उपकरण हैं जिन्हें किसी भी ब्लैक बॉक्स मॉडल पर लागू किया जा सकता है, चाहे वह कितना भी जटिल क्यों न हो। वे मॉडल की आंतरिक संरचना को जाने बिना उसके इनपुट-आउटपुट संबंधों का विश्लेषण करते हैं। यहाँ दो सबसे लोकप्रिय और प्रभावी तकनीकों पर चर्चा की गई है: LIME और SHAP।

1. LIME (Local Interpretable Model-agnostic Explanations)

LIME का मुख्य विचार यह है कि भले ही एक जटिल मॉडल विश्व स्तर पर (globally) अविश्वसनीय हो, वह स्थानीय रूप से (locally) एक साधारण मॉडल द्वारा अच्छी तरह से अनुमानित किया जा सकता है।

- यह कैसे काम करता है:

- एक विशेष भविष्यवाणी (prediction) जिसे आप समझाना चाहते हैं, उसे चुनें।

- उस डेटा पॉइंट के आस-पास (आस-पड़ोस में) कई नए डेटा पॉइंट्स जेनरेट करें।

- इन नए जेनरेटेड डेटा पॉइंट्स पर ब्लैक बॉक्स मॉडल से भविष्यवाणियाँ (predictions) प्राप्त करें।

- इन नए डेटा पॉइंट्स और उनकी भविष्यवाणियों का उपयोग करके, उस स्थानीय क्षेत्र में एक सरल, समझने योग्य मॉडल (जैसे Linear Regression या Decision Tree) को प्रशिक्षित करें।

- यह स्थानीय मॉडल हमें बताता है कि ब्लैक बॉक्स मॉडल ने उस विशेष डेटा पॉइंट के लिए वह भविष्यवाणी क्यों की। यह हमें उन फीचर्स को उजागर करता है जो उस एक भविष्यवाणी के लिए सबसे महत्वपूर्ण थे।

- फायदे:

- स्थानीय व्याख्याएँ (Local explanations) प्रदान करता है, जो वास्तविक दुनिया के परिदृश्यों के लिए बहुत उपयोगी हैं।

- Model-agnostic है, यानी किसी भी ब्लैक बॉक्स मॉडल के साथ काम करता है।

- समझने में अपेक्षाकृत आसान।

- नुकसान:

- ‘आस-पड़ोस’ कैसे परिभाषित किया जाए, यह अक्सर अस्पष्ट होता है।

- स्थानीय मॉडल केवल उस छोटे से क्षेत्र के लिए मान्य होते हैं, वैश्विक व्यवहार का प्रतिनिधित्व नहीं करते।

2. SHAP (SHapley Additive exPlanations)

SHAP एक अधिक सैद्धांतिक रूप से मजबूत तकनीक है जो गेम थ्योरी (Game Theory) के Shapley Values की अवधारणा पर आधारित है। Shapley Values एक cooperative game में प्रत्येक खिलाड़ी को उसके योगदान के लिए एक उचित मूल्य आवंटित करने का एक तरीका है। AI संदर्भ में, ‘खिलाड़ी’ इनपुट फीचर्स हैं और ‘खेल’ मॉडल की भविष्यवाणी है।

- यह कैसे काम करता है:

- SHAP प्रत्येक फीचर के लिए एक मान (SHAP value) असाइन करता है जो यह दर्शाता है कि उस फीचर ने आधारभूत (baseline) भविष्यवाणी से अंतिम भविष्यवाणी में कितना योगदान दिया।

- यह सभी संभावित फीचर कॉम्बिनेशंस (coalitions) पर विचार करके प्रत्येक फीचर के मार्जिनल योगदान का औसत निकालता है। यह प्रक्रिया सुनिश्चित करती है कि प्रत्येक फीचर को उसके सही योगदान के लिए श्रेय मिले, भले ही अन्य फीचर्स मौजूद हों या न हों।

- यह एक additive feature attribution model बनाता है, जहाँ प्रत्येक फीचर के SHAP values का योग आधारभूत से अंतिम भविष्यवाणी तक के अंतर के बराबर होता है।

- फायदे:

- सैद्धांतिक रूप से मजबूत (Shapley values की गणितीय गारंटी पर आधारित)।

- स्थानीय और वैश्विक दोनों प्रकार की व्याख्याएँ प्रदान कर सकता है।

- Features के बीच की बातचीत (interactions) को भी उजागर कर सकता है।

- Model-agnostic है।

- नुकसान:

- गणना में समय लगता है, खासकर बड़ी संख्या में फीचर्स के साथ।

- Shapley values की अवधारणा LIME की तुलना में समझने में थोड़ी अधिक जटिल हो सकती है।

LIME और SHAP दोनों ही जटिल AI मॉडल्स को समझने के लिए अमूल्य उपकरण हैं, जो डेवलपर्स और एंड-यूजर्स दोनों को निर्णयों के पीछे की अंतर्दृष्टि प्रदान करते हैं।

Feature-Based और Counterfactual Explanations

Interpretability Techniques केवल यह बताने तक सीमित नहीं हैं कि मॉडल ने क्या भविष्यवाणी की, बल्कि यह भी समझने में मदद करती हैं कि इनपुट फीचर्स ने उस भविष्यवाणी में कैसे योगदान दिया और यदि इनपुट थोड़ा भिन्न होता तो क्या होता।

1. Feature-Based Explanations (Feature Importance)

यह मॉडल की भविष्यवाणियों में प्रत्येक इनपुट फीचर के सापेक्ष महत्व को समझने पर केंद्रित है। यह हमें बताता है कि कौन से फीचर्स मॉडल के निर्णय को सबसे अधिक प्रभावित कर रहे हैं।

- Global Feature Importance: यह पूरे डेटासेट पर औसतन प्रत्येक फीचर के समग्र प्रभाव को दर्शाता है। उदाहरण के लिए, एक लोन अप्रूवल मॉडल में, ‘क्रेडिट स्कोर’ शायद ‘आय’ से अधिक महत्वपूर्ण ग्लोबल फीचर हो सकता है। यह हमें मॉडल के समग्र व्यवहार की एक उच्च-स्तरीय समझ देता है। SHAP values का उपयोग करके वैश्विक फीचर महत्व को आसानी से प्राप्त किया जा सकता है।

- Local Feature Importance: यह किसी एक विशेष भविष्यवाणी के लिए फीचर्स के महत्व को दर्शाता है। LIME इस प्रकार की व्याख्या का एक बेहतरीन उदाहरण है। एक ग्राहक के लोन अप्रूवल के मामले में, ‘क्रेडिट स्कोर’ और ‘ईएमआई भुगतान इतिहास’ उस एक विशेष ग्राहक के लिए सबसे महत्वपूर्ण फीचर हो सकते हैं।

उदाहरण: एक इमेज क्लासिफिकेशन मॉडल जो किसी तस्वीर में कुत्ते की पहचान करता है, Feature-Based Explanation दिखा सकता है कि कुत्ते के कान, नाक और फर जैसी पिक्सेल विशेषताएँ पहचान के लिए सबसे महत्वपूर्ण थीं।

Feature Importance का उपयोग अक्सर मॉडल को डीबग करने, पूर्वाग्रहों की पहचान करने और यह सुनिश्चित करने के लिए किया जाता है कि मॉडल उन फीचर्स पर ध्यान दे रहा है जिनकी उम्मीद की जाती है।

2. Counterfactual Explanations

Counterfactual Explanations ‘क्या होगा अगर…’ (what if) प्रश्नों का उत्तर देती हैं। वे बताती हैं कि इनपुट में न्यूनतम बदलाव क्या होना चाहिए था ताकि मॉडल की भविष्यवाणी बदल जाए (या वांछित भविष्यवाणी प्राप्त हो सके)।

- यह कैसे काम करता है:

एक उदाहरण से समझते हैं: मान लीजिए, एक AI मॉडल ने किसी व्यक्ति के लोन आवेदन को अस्वीकार कर दिया। एक Counterfactual Explanation यह बता सकता है कि “यदि आपकी मासिक आय ₹50,000 के बजाय ₹60,000 होती, तो आपको लोन मिल जाता।”

तकनीकी रूप से, Counterfactual Explanations वर्तमान इनपुट डेटा पॉइंट के पास के न्यूनतम परिवर्तनों की पहचान करती हैं जो मॉडल के आउटपुट को वांछित लक्ष्य आउटपुट में बदल देंगे।

- फायदे:

- कार्य योग्य अंतर्दृष्टि (Actionable insights) प्रदान करता है: यह उपयोगकर्ता को बताता है कि उन्हें क्या बदलने की आवश्यकता है ताकि वे वांछित परिणाम प्राप्त कर सकें।

- मानव-समझने योग्य: ‘क्या होगा अगर…’ का प्रारूप मनुष्यों के लिए स्वाभाविक रूप से समझने योग्य है।

- निर्णयों को fairer बनाने में मदद करता है: यदि किसी को अस्वीकृत किया जाता है, तो वे समझ सकते हैं कि उन्हें भविष्य में सफल होने के लिए क्या करना होगा।

- नुकसान:

- कई काउंटरफैक्चुअल हो सकते हैं, उनमें से सबसे उपयोगी को चुनना मुश्किल हो सकता है।

- कभी-कभी, सुझाए गए परिवर्तन अव्यावहारिक या असंभव हो सकते हैं (जैसे ‘यदि आप युवा होते तो आपको लोन मिल जाता’)।

Counterfactual Explanations विशेष रूप से उन परिदृश्यों में मूल्यवान हैं जहाँ उपयोगकर्ताओं को AI निर्णयों को प्रभावित करने के लिए मार्गदर्शन की आवश्यकता होती है। वे AI निर्णयों के लिए एक ‘नुस्खा’ प्रदान करते हैं, जो ब्लैक बॉक्स मॉडल्स को अधिक user-friendly और उत्तरदायी बनाता है।

निष्कर्ष

Explainable AI (XAI) और विशेष रूप से Interpretability Techniques, आज के AI परिदृश्य में अत्यंत महत्वपूर्ण हो गई हैं। हमने देखा कि कैसे White Box मॉडल्स स्वाभाविक रूप से Transparent होते हैं, जबकि Black Box मॉडल्स के लिए हमें LIME और SHAP जैसी शक्तिशाली Model-Agnostic तकनीकों का सहारा लेना पड़ता है। ये तकनीकें हमें AI निर्णयों के पीछे की जटिलताओं को समझने में मदद करती हैं, चाहे वह किसी एक भविष्यवाणी के लिए फीचर्स का स्थानीय महत्व हो या पूरे मॉडल के व्यवहार पर फीचर्स का वैश्विक प्रभाव। इसके अलावा, Counterfactual Explanations हमें ‘क्या होगा अगर’ जैसे महत्वपूर्ण सवालों के जवाब देकर actionable insights प्रदान करती हैं, जिससे उपयोगकर्ता AI निर्णयों को प्रभावित करने के लिए आवश्यक कदम उठा सकते हैं।

AI के बढ़ते उपयोग के साथ, Trust, Accountability, Fairness और Regulatory Compliance सुनिश्चित करने के लिए XAI की भूमिका और भी महत्वपूर्ण होती जाएगी। Interpretability Techniques हमें न केवल AI मॉडल्स को डीबग करने और सुधारने में मदद करती हैं, बल्कि हमें AI पर विश्वास करने और उसे जिम्मेदारी से उपयोग करने का आधार भी प्रदान करती हैं। भविष्य में, AI सिस्टम्स की Explainability एक लग्जरी नहीं, बल्कि एक आवश्यकता होगी, जो AI को हमारे समाज में और अधिक सहजता से एकीकृत करेगी।