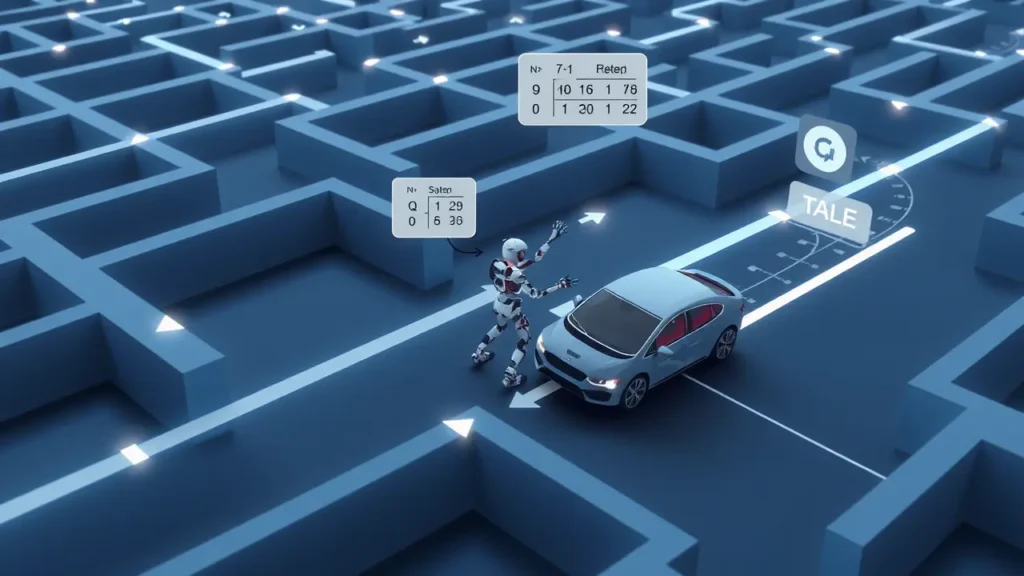

Reinforcement Learning (RL) मशीन लर्निंग का एक प्रकार है, जहां एक एजेंट (Agent) अपने एनवायरनमेंट (Environment) के साथ इंटरैक्ट करके ऑप्टिमल एक्शन्स (Optimal Actions) सीखता है। इसका मुख्य उद्देश्य क्यूम्युलेटिव रिवार्ड (Cumulative Reward) को मैक्सिमाइज़ करना होता है। यह सीखने की प्रक्रिया ट्रायल एंड एरर (Trial and Error) पर आधारित होती है, जहां एजेंट को अच्छे एक्शन्स के लिए रिवार्ड और बुरे एक्शन्स के लिए पेनल्टी मिलती है।

1. Reinforcement Learning कैसे काम करता है?

- एजेंट (Agent): वह इकाई जो निर्णय लेती है (जैसे: रोबोट, गेम-प्लेइंग AI)।

- एनवायरनमेंट (Environment): वह दुनिया जहां एजेंट काम करता है (जैसे: गेम का बोर्ड, सड़क)।

- स्टेट (State): एनवायरनमेंट की वर्तमान स्थिति (जैसे: गेम में खिलाड़ी की पोजीशन)।

- एक्शन (Action): एजेंट द्वारा किया जाने वाला कदम (जैसे: बाएं चलना, कूदना)।

- रिवार्ड (Reward): एक्शन के परिणामस्वरूप मिलने वाला फीडबैक (जैसे: +10 पॉइंट, -5 पॉइंट)।

प्रक्रिया:

- एजेंट एनवायरनमेंट को ऑब्ज़र्व (Observe) करता है और करंट स्टेट पहचानता है।

- वह पॉलिसी (Policy) के अनुसार एक एक्शन चुनता है।

- एक्शन के बाद, उसे रिवार्ड/पेनल्टी मिलती है और एनवायरनमेंट नया स्टेट दिखाता है।

- एजेंट अपने अनुभव से सीखकर ऑप्टिमल पॉलिसी (Optimal Policy) बनाता है।

2. मुख्य अवधारणाएँ (Key Concepts)

- पॉलिसी (Policy):

- एजेंट का निर्णय लेने का नियम (जैसे: “स्टेट A में एक्शन X करो”)।

- यह एक फंक्शन है जो स्टेट्स को एक्शन्स में मैप करता है।

- रिवार्ड फंक्शन (Reward Function):

- यह बताता है कि किसी स्टेट या एक्शन से कितना रिवार्ड मिलेगा।

- वैल्यू फंक्शन (Value Function):

- किसी स्टेट का “लॉन्ग-टर्म वैल्यू” जो भविष्य के रिवार्ड्स को ध्यान में रखता है।

- Q-Learning:

- एक मॉडल-फ्री (Model-Free) एल्गोरिदम जो Q-वैल्यू सीखता है (Q(s,a) = स्टेट ‘s’ में एक्शन ‘a’ का अपेक्षित रिवार्ड)।

- एक्सप्लोरेशन vs एक्सप्लॉइटेशन (Exploration vs Exploitation):

- एक्सप्लोरेशन: नए एक्शन्स ट्राई करके ज्यादा जानकारी इकट्ठा करना।

- एक्सप्लॉइटेशन: पहले से सीखे गए बेस्ट एक्शन्स का उपयोग करना।

3. Reinforcement Learning के प्रकार (Types of RL)

- मॉडल-बेस्ड RL (Model-Based RL):

- एजेंट को एनवायरनमेंट का मॉडल पहले से पता होता है (जैसे: चेस गेम के नियम)।

- मॉडल-फ्री RL (Model-Free RL):

- एजेंट को एनवायरनमेंट का मॉडल नहीं पता होता (जैसे: Q-Learning)।

- ऑन-पॉलिसी vs ऑफ-पॉलिसी (On-Policy vs Off-Policy):

- ऑन-पॉलिसी: एजेंट उसी पॉलिसी का उपयोग करता है जिससे वह सीख रहा है (जैसे: SARSA)।

- ऑफ-पॉलिसी: एजेंट सीखने के लिए अलग पॉलिसी का उपयोग करता है (जैसे: Q-Learning)।

4. RL के प्रमुख एल्गोरिदम (Popular Algorithms)

- Q-Learning: स्टेट-एक्शन पेयर्स के वैल्यू को अपडेट करता है।

- Deep Q-Networks (DQN): Q-Learning को न्यूरल नेटवर्क के साथ जोड़ता है।

- Policy Gradients: सीधे पॉलिसी को ऑप्टिमाइज़ करता है।

- A3C (Asynchronous Advantage Actor-Critic): एजेंट्स को समानांतर में ट्रेन करता है।

5. RL के उपयोग (Applications)

- गेमिंग (Gaming): AlphaGo, Chess Engines, Video Game AI।

- रोबोटिक्स (Robotics): रोबोट को चलना या ऑब्जेक्ट उठाना सिखाना।

- सेल्फ-ड्राइविंग कार्स (Self-Driving Cars): ट्रैफिक नियमों और रास्तों को सीखना।

- रिकमेंडेशन सिस्टम्स (Recommendation Systems): यूजर प्रेफरेंस के आधार पर पर्सनलाइज्ड सुझाव।

6. फायदे और सीमाएँ (Advantages & Limitations)

| फायदे | सीमाएँ |

|---|---|

| कॉम्प्लेक्स एनवायरनमेंट्स को हैंडल करता है। | ट्रेनिंग में बहुत डेटा और समय लगता है। |

| रियल-टाइम डिसीजन लेने की क्षमता। | एक्सप्लोरेशन-एक्सप्लॉइटेशन डाइलेम्मा। |

| ह्यूमन-लाइक लर्निंग प्रोसेस। | रिवार्ड फंक्शन डिजाइन करना मुश्किल। |

7. निष्कर्ष (Conclusion)

Reinforcement Learning, AI की वह शाखा है जहां मशीनें अपने अनुभव से सीखती हैं। यह टेक्नोलॉजी गेमिंग से लेकर रोबोटिक्स तक क्रांतिकारी बदलाव ला रही है। हालांकि, इसमें चुनौतियाँ (जैसे: डेटा की जरूरत, कंप्यूटेशनल कॉस्ट) हैं, लेकिन Deep RL और एडवांस्ड एल्गोरिदम्स के साथ इसका भविष्य उज्ज्वल है। 🤖🎮