आज की दुनिया में आर्टिफिशियल इंटेलिजेंस (AI) हर जगह है, और इसका एक महत्वपूर्ण हिस्सा है मशीन लर्निंग (ML)। ML AI को डेटा से सीखने और भविष्यवाणियां करने में मदद करता है। ML के भीतर कई प्रकार के लर्निंग approaches हैं, जिनमें से एक बहुत ही पावरफुल technique है Reinforcement Learning (RL)। RL में, एक agent एक environment के साथ इंटरैक्ट करके सीखता है, जैसे एक बच्चा खेल-खेल में सीखता है। वह सही कामों के लिए रिवॉर्ड (पुरस्कार) और गलत कामों के लिए पेनल्टी (दंड) पाता है। इसी Reinforcement Learning का एक बहुत ही लोकप्रिय और fundamental algorithm है Q-Learning, जिस पर हम इस लेख में गहराई से चर्चा करेंगे। यह algorithms AI agents को smartest decisions लेने में मदद करता है।

AI और Machine Learning (ML) को समझना

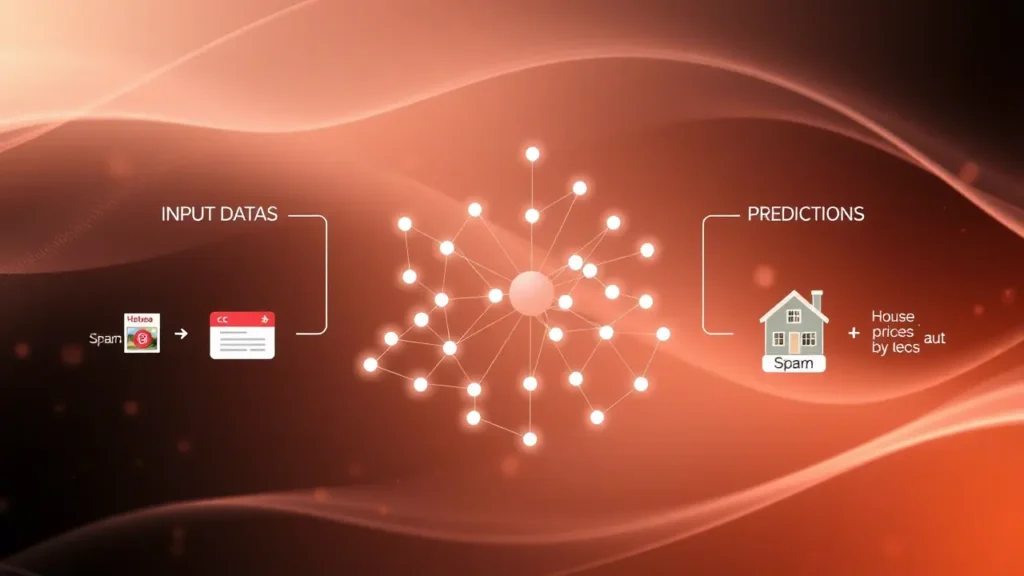

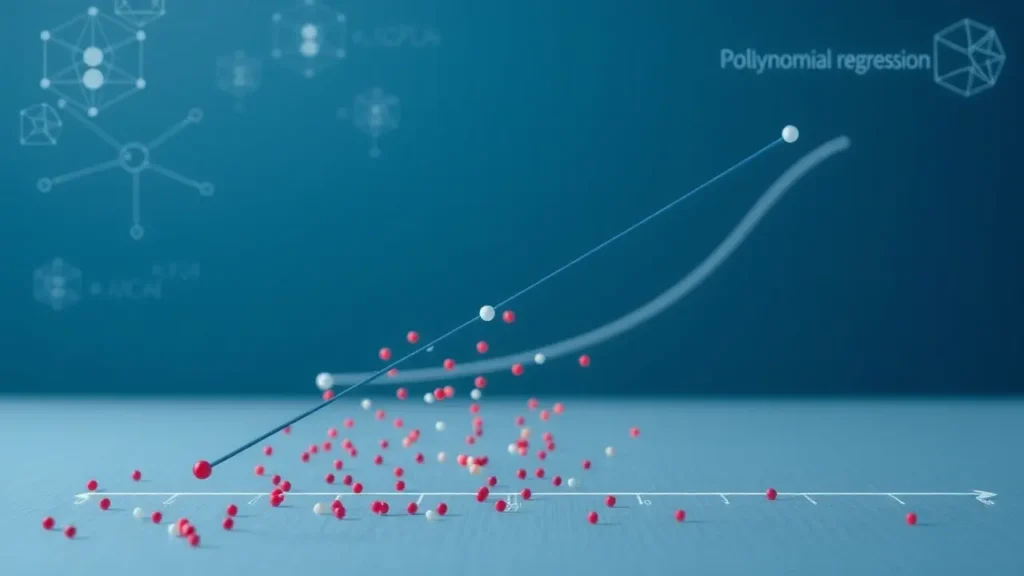

AI, या आर्टिफिशियल इंटेलिजेंस, मशीनों को इंसानों की तरह सोचने और काम करने की क्षमता देने का science है। इसका लक्ष्य ऐसी intelligence बनाना है जो समस्याओं को हल कर सके, सीख सके और निर्णय ले सके। Machine Learning (ML) AI का एक subset है जो computers को explicit programming के बिना डेटा से सीखने की अनुमति देता है। इसका मतलब है कि आप मशीन को हर एक नियम बताने के बजाय उसे डेटा देते हैं, और वह खुद ही patterns को पहचानना और decisions लेना सीख जाती है।

ML को मुख्य रूप से तीन तरीकों में बांटा गया है: Supervised Learning, Unsupervised Learning और Reinforcement Learning। Supervised Learning में, मॉडल labeled data से सीखता है (जैसे बिल्लियों और कुत्तों की labeled तस्वीरें)। Unsupervised Learning में, मॉडल unlabeled data में patterns ढूंढता है (जैसे ग्राहकों को उनके खरीदने के पैटर्न के आधार पर group करना)। Reinforcement Learning इन दोनों से अलग है और एक unique learning approach प्रदान करता है।

Reinforcement Learning क्या है? (The “Learning by Doing” Approach)

Reinforcement Learning (RL) एक ऐसा ML approach है जहाँ एक agent को किसी environment में sequential decisions लेने के लिए train किया जाता है। इसकी प्रेरणा जानवरों या इंसानों के सीखने के तरीके से आती है – ‘trial and error’ (प्रयास और त्रुटि) के माध्यम से। एक एजेंट को एक goal दिया जाता है, और उसे उस गोल तक पहुँचने के लिए सबसे अच्छे तरीकों का पता लगाना होता है।

RL के मुख्य components हैं:

- Agent: यह वह इकाई है जो decisions लेती है और environment में actions perform करती है।

- Environment: यह वह दुनिया है जिसके साथ agent इंटरैक्ट करता है। यह agent की actions के response में एक नया state और reward प्रदान करता है।

- State: environment की वर्तमान स्थिति।

- Action: agent द्वारा environment में की गई गतिविधि।

- Reward: agent को उसकी action के लिए environment से मिलने वाला feedback। पॉजिटिव रिवॉर्ड अच्छे actions के लिए होते हैं, और नेगेटिव रिवॉर्ड (penalty) बुरे actions के लिए।

- Policy: यह वह strategy है जो agent को बताती है कि किसी दी गई state में कौन सी action लेनी चाहिए।

RL का objective agent के लिए एक optimal policy खोजना है जो समय के साथ कुल reward को maximise कर सके। यह Supervised Learning से अलग है क्योंकि यहाँ कोई labeled training data नहीं होता; agent को खुद ही experiment करके सीखना पड़ता है।

Q-Learning की गहराई में: कैसे यह काम करता है?

Q-Learning, Reinforcement Learning का एक model-free algorithm है। “Model-free” का मतलब है कि agent को environment के पूरे dynamics (जैसे environment कैसे काम करता है, actions के क्या परिणाम होंगे) को जानने की आवश्यकता नहीं होती। यह algorithm agent को हर state-action pair के लिए एक Q-value असाइन करके एक optimal policy सीखने में मदद करता है। Q-value यह अनुमान लगाता है कि किसी particular state में एक specific action लेने के बाद भविष्य में कितना अधिकतम cumulative reward मिलेगा।

Q-Learning में, एक Q-table का उपयोग किया जाता है। यह एक matrix होती है जिसमें rows states को represent करती हैं और columns actions को। हर cell (राज्य, क्रिया) के intersection पर corresponding Q-value स्टोर होती है। शुरुआत में, ये Q-values random होती हैं या zero पर सेट होती हैं। agent environment में actions लेता है और अपने अनुभव के आधार पर इन Q-values को update करता है।

Q-value को update करने के लिए Bellman Equation का एक modified version उपयोग किया जाता है:

Q(s, a) ← Q(s, a) + α [r + γ maxa' Q(s', a') - Q(s, a)]

यहाँ:

Q(s, a): वर्तमान statesमें actionaलेने के लिए Q-value।α(alpha): Learning Rate, जो बताता है कि agent नई जानकारी को कितनी तेज़ी से स्वीकार करता है (0 और 1 के बीच)।r: वर्तमान action के लिए immediate reward।γ(gamma): Discount Factor, जो भविष्य के rewards के महत्व को दर्शाता है (0 और 1 के बीच)।maxa' Q(s', a'): अगली states'में सभी संभावित actionsa'के लिए अधिकतम Q-value।Q(s, a): पुरानी Q-value।

agent को ‘exploration’ (नए actions की खोज) और ‘exploitation’ (जो actions पहले से अच्छे proven हुए हैं उन्हें लेना) के बीच एक संतुलन बनाना होता है। आमतौर पर, learning process की शुरुआत में exploration अधिक होता है और धीरे-धीरे exploitation की ओर बढ़ता है ताकि agent सबसे अच्छी policy सीख सके।

Q-Learning के फायदे और इसकी Applications

Q-Learning के कई significant फायदे हैं जो इसे Reinforcement Learning में एक powerful tool बनाते हैं:

- Model-Free: जैसा कि पहले बताया गया है, इसे environment के dynamics के बारे में किसी पूर्व ज्ञान की आवश्यकता नहीं होती। यह सीधे अनुभव से सीखता है।

- Optimal Policy Convergence: सही परिस्थितियों में, Q-Learning algorithm guarantee करता है कि यह एक optimal policy में converge हो जाएगा, जिसका अर्थ है कि agent अंततः सबसे अच्छे निर्णय लेना सीख जाएगा।

- Simplicity: इसकी अवधारणा और implementation अपेक्षाकृत सरल है, खासकर discrete state और action spaces के लिए।

Q-Learning की applications बहुत विविध हैं और वास्तविक दुनिया की कई समस्याओं को हल करने में मदद करती हैं। कुछ प्रमुख examples हैं:

- Robotics: रोबोट्स को complex tasks (जैसे चलना, वस्तुओं को उठाना) को environment के साथ इंटरैक्ट करके सीखने में मदद करता है।

- Gaming: AI players को वीडियो गेम्स में human-like या superhuman performance हासिल करने के लिए train किया जाता है, जैसे AlphaGo या Atari games।

- Recommendation Systems: personalized recommendations देने के लिए यूजर के past behavior और preferences के आधार पर optimal strategies तय करना।

- Autonomous Driving: सेल्फ-ड्राइविंग कारों को traffic situations में safe और efficient decisions लेने के लिए train करना।

- Resource Management: ऊर्जा ग्रिड या नेटवर्क ट्रैफिक को अनुकूलित (optimize) करना।

यह Algorithm AI agents को बिना किसी पूर्व ज्ञान के, केवल अनुभव और रिवॉर्ड के आधार पर complex environments में expert बनने का मार्ग दिखाता है।

निष्कर्ष

संक्षेप में, हमने AI और Machine Learning के व्यापक क्षेत्र से शुरुआत की, और फिर Reinforcement Learning की ‘learning by doing’ approach को समझा। Q-Learning इसी Reinforcement Learning का एक fundamental और highly effective algorithm है जो agent को एक Q-table का उपयोग करके हर state-action pair के लिए optimal Q-values सीखने में मदद करता है। यह algorithm बिना environment मॉडल के, trial and error और reward system के माध्यम से सबसे अच्छी निर्णय लेने की strategy (optimal policy) बनाता है। इसकी model-free प्रकृति और optimal policy तक पहुँचने की क्षमता इसे robotics, gaming, autonomous systems और recommendation systems जैसे विभिन्न क्षेत्रों में invaluable बनाती है। Q-Learning AI को एक smarter और अधिक adaptive भविष्य की ओर ले जाने में एक महत्वपूर्ण भूमिका निभाता रहेगा, जिससे machines हमारी दुनिया के साथ और अधिक कुशलता से इंटरैक्ट कर सकेंगी।