आज की डिजिटल दुनिया में Artificial Intelligence (AI) और Machine Learning (ML) जैसे शब्द हर जगह सुनने को मिलते हैं। ये सिर्फ buzzwords नहीं हैं, बल्कि ऐसी टेक्नोलॉजीज़ हैं जो हमारे भविष्य को आकार दे रही हैं। इस लेख में, हम AI की गहराइयों में उतरेंगे और इसके एक महत्वपूर्ण ब्रांच, Deep Learning (DL) को समझेंगे। हम जानेंगे कि कैसे Deep Learning, Neural Networks नामक दिमागी संरचनाओं पर आधारित है और कैसे इन Neural Networks की सबसे बुनियादी इकाई, एक साधारण से Perceptron ने AI की दुनिया में क्रांति ला दी। हमारा सफर AI की विशाल दुनिया से शुरू होकर Perceptron की मूलभूत अवधारणा तक जाएगा, जो आधुनिक AI का आधार है।

AI और Deep Learning की दुनिया में आपका स्वागत है

Artificial Intelligence (AI) एक ऐसा क्षेत्र है जहाँ मशीनें इंसानों की तरह सोचने, सीखने और समस्याओं को हल करने की क्षमता हासिल करती हैं। AI के भीतर कई उप-क्षेत्र (sub-fields) हैं, और उनमें से एक प्रमुख है Machine Learning (ML)। Machine Learning कंप्यूटर को स्पष्ट रूप से प्रोग्राम किए बिना डेटा से सीखने की क्षमता देता है।

Machine Learning का एक और उन्नत रूप है Deep Learning (DL)। Deep Learning, Machine Learning का एक subset है जो मानव मस्तिष्क की संरचना और कार्यप्रणाली से प्रेरित Artificial Neural Networks का उपयोग करता है। Deep Learning मॉडल्स बहुत बड़े डेटासेट्स (datasets) से complex patterns को सीख सकते हैं, जैसे कि इमेज, साउंड और टेक्स्ट। इसी क्षमता के कारण यह इमेज रिकॉग्निशन (image recognition), नेचुरल लैंग्वेज प्रोसेसिंग (natural language processing) और autonomous vehicles जैसे क्षेत्रों में बेहद सफल रहा है। Deep Learning एल्गोरिदम में कई परतें (layers) होती हैं जो डेटा को पदानुक्रमित तरीके से प्रोसेस करती हैं, जिससे वे अधिक जटिल संबंधों को समझ पाती हैं।

Neural Networks: दिमाग से प्रेरित संरचनाएँ

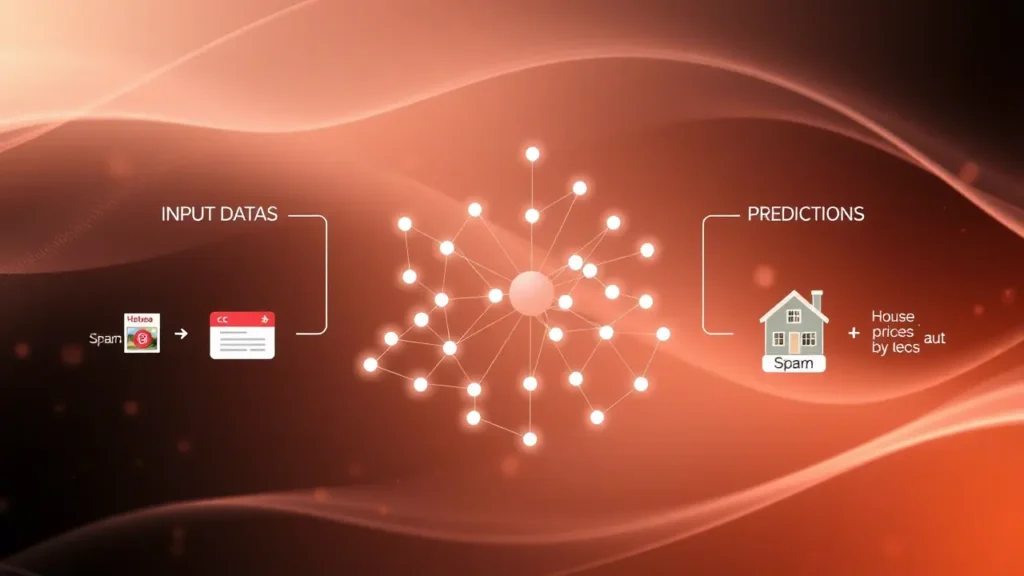

Deep Learning का मूल आधार Neural Networks हैं। एक Neural Network, जिसे Artificial Neural Network (ANN) भी कहा जाता है, इंटरकनेक्टेड नोड्स (nodes) की एक श्रृंखला है जो जैविक मस्तिष्क में न्यूरॉन्स (neurons) की तरह काम करती है। ये नोड्स, या “न्यूरॉन्स”, इनपुट डेटा लेते हैं, कुछ कैलकुलेशन करते हैं और फिर आउटपुट (output) देते हैं।

एक साधारण Neural Network में आमतौर पर तीन प्रकार की परतें होती हैं:

- इनपुट लेयर (Input Layer): यह वह जगह है जहाँ डेटा नेटवर्क में फीड किया जाता है। प्रत्येक नोड एक इनपुट फीचर (input feature) का प्रतिनिधित्व करता है।

- हिडन लेयर्स (Hidden Layers): इनपुट और आउटपुट लेयर्स के बीच की परतें, जहाँ वास्तविक कंप्यूटेशन और पैटर्न डिटेक्शन होता है। एक Deep Learning नेटवर्क में कई हिडन लेयर्स हो सकती हैं।

- आउटपुट लेयर (Output Layer): यह परत नेटवर्क द्वारा दिए गए अंतिम परिणाम या प्रेडिक्शन को प्रस्तुत करती है।

ये न्यूरॉन्स “वजन” (weights) और “बायस” (biases) नामक पैरामीटर्स के माध्यम से एक-दूसरे से जुड़े होते हैं। नेटवर्क ट्रेनिंग के दौरान इन weights और biases को एडजस्ट करके सीखता है, जिससे यह इनपुट और आउटपुट के बीच के संबंधों को बेहतर ढंग से समझ पाता है। एक्टिवेशन फंक्शन (activation function) प्रत्येक न्यूरॉन के आउटपुट को निर्धारित करने में महत्वपूर्ण भूमिका निभाता है, यह तय करता है कि न्यूरॉन “फायर” करेगा या नहीं।

Perceptron: न्यूरल नेटवर्क की नींव

किसी भी Artificial Neural Network की सबसे बुनियादी इकाई और सबसे सरल रूप है Perceptron। इसे 1957 में Frank Rosenblatt ने विकसित किया था। Perceptron एक बाइनरी क्लासिफायर (binary classifier) है, जिसका अर्थ है कि यह इनपुट डेटा को दो अलग-अलग कैटेगरी (categories) में वर्गीकृत कर सकता है, जैसे “हाँ” या “नहीं”, “सत्य” या “असत्य”, “स्पैम” या “नॉन-स्पैम”।

एक Perceptron कैसे काम करता है, इसे समझने के लिए, इसके मुख्य कंपोनेंट्स को देखते हैं:

- इनपुट्स (Inputs): यह कई इनपुट वैल्यूज़ (x1, x2, …, xn) लेता है।

- वजन (Weights): प्रत्येक इनपुट के साथ एक weight (w1, w2, …, wn) जुड़ा होता है। ये weights तय करते हैं कि किसी खास इनपुट का आउटपुट पर कितना प्रभाव पड़ेगा।

- भारित योग (Weighted Sum): सभी इनपुट्स को उनके संबंधित weights से गुणा किया जाता है और फिर उन सभी को जोड़ दिया जाता है (∑(xi * wi))। इसमें एक bias टर्म (b) भी जोड़ा जाता है, जो मॉडल को अधिक लचीला बनाता है।

- एक्टिवेशन फंक्शन (Activation Function): भारित योग को एक स्टेप फंक्शन (step function) या थ्रेशोल्ड फंक्शन (threshold function) जैसे एक्टिवेशन फंक्शन के माध्यम से पास किया जाता है। यह फंक्शन तय करता है कि आउटपुट 0 होगा या 1। यदि योग एक निश्चित थ्रेशोल्ड (threshold) से अधिक है, तो आउटपुट 1 होता है, अन्यथा 0।

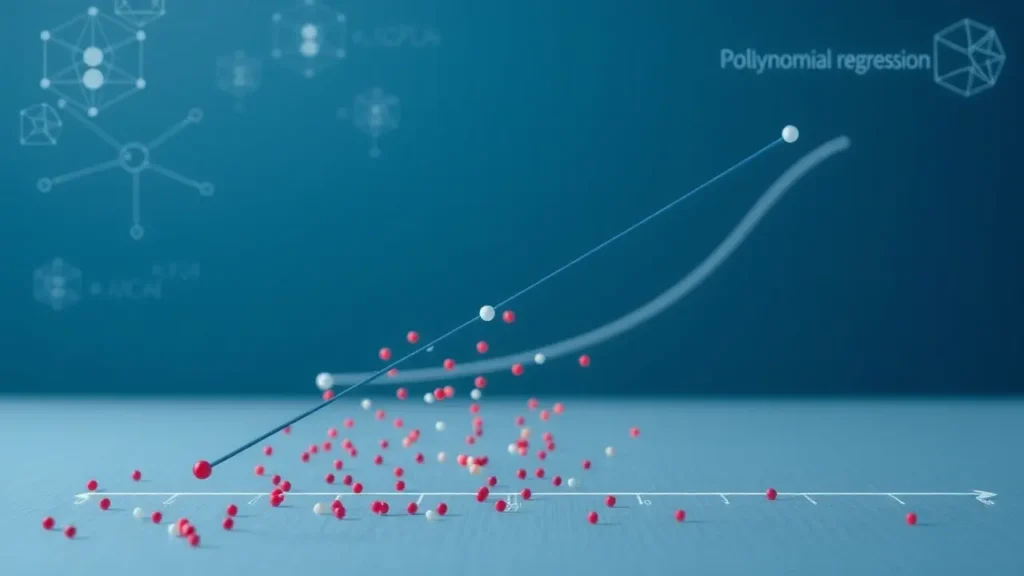

सरल होने के बावजूद, Perceptron ने AI में क्रांति ला दी क्योंकि इसने दिखाया कि मशीनें डेटा से सीख सकती हैं और निर्णय ले सकती हैं। हालांकि, इसकी एक बड़ी सीमा थी: यह केवल लाइनियरली सेपरेबल (linearly separable) समस्याओं को ही हल कर सकता था। इसका मतलब है कि यह उन डेटासेट्स को वर्गीकृत नहीं कर सकता था जिन्हें एक सीधी रेखा द्वारा अलग नहीं किया जा सकता था (जैसे XOR गेट समस्या)।

Perceptrons से Deep Learning तक का सफर

Perceptron की सीमा को पहचानते हुए, शोधकर्ताओं ने इसे और विकसित करने पर काम किया। यहीं से मल्टी-लेयर परसेप्ट्रॉन (Multi-Layer Perceptron – MLP) का विचार आया। MLPs में एक इनपुट लेयर, एक या एक से अधिक हिडन लेयर्स और एक आउटपुट लेयर होती है। प्रत्येक हिडन लेयर में कई Perceptron-जैसे न्यूरॉन्स होते हैं जो आपस में जुड़े होते हैं। हिडन लेयर्स की शुरुआत ने नेटवर्क को नॉन-लाइनियरली सेपरेबल (non-linearly separable) समस्याओं को हल करने की क्षमता दी, जिससे यह बहुत अधिक शक्तिशाली हो गया।

MLPs को प्रशिक्षित करने के लिए बैकप्रोपेगेशन (backpropagation) नामक एक एल्गोरिदम विकसित किया गया। यह एल्गोरिदम नेटवर्क के आउटपुट में त्रुटि (error) को मापता है और फिर उस त्रुटि को वापस हिडन लेयर्स में “प्रोपोगेट” करता है, जिससे weights और biases को एडजस्ट किया जा सके ताकि अगले अनुमान में त्रुटि कम हो। यह iterative प्रोसेस नेटवर्क को लगातार सीखने और बेहतर होने में मदद करता है।

आज के अत्याधुनिक Deep Learning मॉडल, जैसे कि Convolutional Neural Networks (CNNs) इमेज प्रोसेसिंग के लिए या Recurrent Neural Networks (RNNs) सीक्वेंस डेटा के लिए, MLPs के ही उन्नत और जटिल रूप हैं। इन सभी मॉडलों के मूल में कहीं न कहीं Perceptron का सिद्धांत निहित है। Perceptron ने एक बिल्डिंग ब्लॉक प्रदान किया, जिसके ऊपर आज के शक्तिशाली AI सिस्टम खड़े किए गए हैं। यह समझना कि एक साधारण Perceptron कैसे काम करता है, हमें पूरे Neural Network आर्किटेक्चर को समझने की गहरी अंतर्दृष्टि देता है।

इस पूरे सफर में, हमने देखा कि कैसे Artificial Intelligence की व्यापक दुनिया से हम Deep Learning के विशिष्ट क्षेत्र में पहुंचे। Deep Learning, जिसने आधुनिक AI को आकार दिया है, Neural Networks नामक दिमागी संरचनाओं पर आधारित है। इन Neural Networks की सबसे बुनियादी इकाई एक साधारण Perceptron है। Perceptron, जो इनपुट को लेकर बाइनरी आउटपुट देता है, Neural Networks का एक छोटा लेकिन शक्तिशाली बिल्डिंग ब्लॉक है। इसकी सीमाओं को मल्टी-लेयर परसेप्ट्रॉन और बैकप्रोपेगेशन जैसे नवाचारों द्वारा दूर किया गया, जिससे आज के जटिल Deep Learning मॉडल विकसित हुए। Perceptron से शुरू होकर, AI ने शानदार प्रगति की है, और इन मूलभूत अवधारणाओं को समझना AI की शक्ति और क्षमता को पूरी तरह से सराहना करने के लिए महत्वपूर्ण है। AI का भविष्य निश्चित रूप से और भी रोमांचक संभावनाओं से भरा होगा, और यह सब Perceptron जैसे सरल लेकिन मूलभूत विचारों से संभव हुआ है।