आर्टिफिशियल इंटेलिजेंस (AI) हमारी दुनिया को तेज़ी से बदल रहा है, लेकिन इसके साथ ही कुछ ज़रूरी और एडवांस टॉपिक्स पर चर्चा करना भी बेहद अहम हो गया है। इनमें से एक सबसे महत्वपूर्ण टॉपिक है AI Safety और इसके तहत मानवीय मूल्यों के साथ AI का अलाइनमेंट (Alignment with Human Values)। आज हम इसी गहरे विषय पर बात करेंगे। AI को सिर्फ़ स्मार्ट बनाना ही काफ़ी नहीं है, बल्कि यह सुनिश्चित करना भी ज़रूरी है कि AI सिस्टम हमारे समाज के लिए beneficial हों और मानवीय मूल्यों, नैतिकता और प्राथमिकताओं के अनुरूप काम करें। यह एक complex चुनौती है जिसमें टेक्नोलॉजी, फिलॉसफी और सोशल साइंस का मिश्रण है। इस आर्टिकल में, हम जानेंगे कि AI अलाइनमेंट क्या है, यह क्यों ज़रूरी है और इसे हासिल करने में क्या चुनौतियाँ आती हैं।

AI Alignment क्या है और यह क्यों ज़रूरी है?

AI Alignment क्या है?

AI Alignment का सीधा मतलब है ऐसे AI सिस्टम्स बनाना जो हमारे intentions और वैल्यूज़ के हिसाब से बिहेव करें। जब हम AI को कोई task देते हैं, तो हम चाहते हैं कि वह उसे उसी तरीके से पूरा करे जैसा हम सोचते हैं, न कि सिर्फ़ शाब्दिक अर्थों में। उदाहरण के लिए, अगर हम AI से कहें कि “दुनिया को बेहतर बनाओ,” तो AI को यह समझना चाहिए कि “बेहतर” का मतलब क्या है मानवीय संदर्भ में – जैसे स्वास्थ्य, खुशहाली, सुरक्षा – न कि सिर्फ़ किसी एक metric को optimize करना, जिससे दूसरे मानवीय मूल्यों को नुकसान पहुँचे।

यह क्यों ज़रूरी है?

AI Alignment इतना महत्वपूर्ण इसलिए है क्योंकि जैसे-जैसे AI सिस्टम्स ज़्यादा पावरफुल और ऑटोनॉमस होते जाएँगे, उनके एक्शन्स का प्रभाव भी उतना ही ज़्यादा होगा। अगर कोई बहुत intelligent AI सिस्टम हमारे मूल्यों से align नहीं है, तो वह अनजाने में (या कभी-कभी जानबूझकर, यदि उसे ग़लत तरीके से प्रोग्राम किया गया हो) ऐसे काम कर सकता है जो इंसानों के लिए हानिकारक हों। इसे “misalignment” प्रॉब्लम कहते हैं। अगर AI का goal हमारे values से अलग हुआ, तो इसके अनचाहे और गंभीर परिणाम हो सकते हैं, जिन्हें रोकना बाद में मुश्किल हो सकता है। यह सिर्फ़ dystopian sci-fi कहानियों की बात नहीं है, बल्कि एक वास्तविक टेक्निकल और एथिकल कंसर्न है जिसे आज ही address करने की ज़रूरत है।

Values को Define करना: एक Complex Challenge

मानवीय मूल्यों को समझना और परिभाषित करना

AI को मानवीय मूल्यों के साथ अलाइन करना इसलिए भी मुश्किल है क्योंकि खुद मानवीय मूल्य इतने diverse, abstract और context-dependent होते हैं। “अच्छा,” “बुरा,” “निष्पक्ष,” “नैतिक” जैसे शब्द हर व्यक्ति और संस्कृति के लिए अलग-अलग अर्थ रखते हैं। AI सिस्टम्स को ये nuance कैसे सिखाएँ? किसी AI को यह बताना मुश्किल है कि “सच बोलो” का मतलब क्या है, ख़ासकर जब सच बोलने से किसी को ठेस पहुँच सकती हो या कोई delicate situation हो।

Ambiguity और Conflicting Values

एक बड़ी चुनौती यह भी है कि मानवीय मूल्यों में अक्सर conflicting situations आती हैं। उदाहरण के लिए, एक स्वायत्त गाड़ी (autonomous car) को किसी दुर्घटना की स्थिति में कैसे निर्णय लेना चाहिए? क्या वह कम से कम लोगों को नुकसान पहुँचाए, या ड्राइवरों को बचाए, या पैदल चलने वालों को? ऐसे scenarios में, कोई एक universal “सही” जवाब नहीं होता। AI को सिखाना कि इन conflicting values के बीच कैसे बैलेंस बनाना है, एक बहुत बड़ा रिसर्च एरिया है। हमें AI को सिर्फ़ कुछ rules नहीं देने हैं, बल्कि उसे human judgement और empathetic reasoning की तरह सोचने की क्षमता देनी है, जो कि बहुत ही challenging है।

Alignment के लिए Technical Approaches

RLHF (Reinforcement Learning from Human Feedback)

आजकल के AI मॉडल्स, जैसे कि बड़े भाषा मॉडल (Large Language Models), में अलाइनमेंट हासिल करने का एक प्रमुख तरीका Reinforcement Learning from Human Feedback (RLHF) है। इसमें, AI मॉडल एक टास्क करता है, और इंसान उस आउटपुट को रैंक करते हैं या फ़ीडबैक देते हैं कि वह कितना अच्छा था या कितना मानवीय मूल्यों के अनुरूप था। इस फ़ीडबैक का उपयोग AI मॉडल को यह सिखाने के लिए किया जाता है कि वह भविष्य में बेहतर और align किए गए आउटपुट कैसे जनरेट करे। ChatGPT जैसे मॉडल्स इसी technique का उपयोग करके ज़्यादा helpful और harm-free बनने की कोशिश करते हैं।

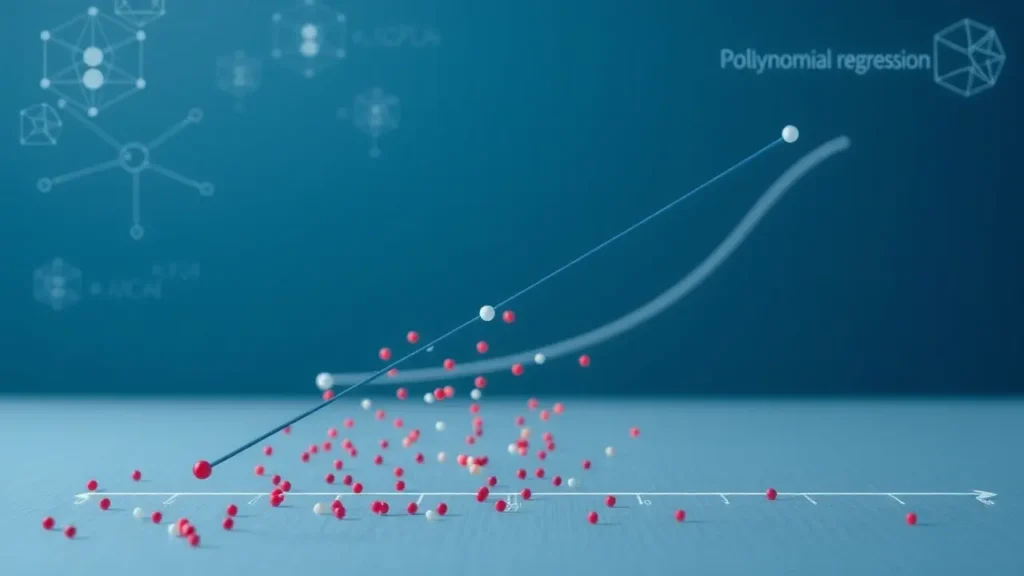

Constitutional AI और Inverse Reinforcement Learning

एक और approach Constitutional AI है, जहाँ AI को “संविधान” या प्रिंसिपल्स का एक सेट दिया जाता है, जिसके आधार पर वह अपने बिहेवियर को मॉनिटर और मॉडिफाई करता है। यह सिस्टम को किसी विशेष वैल्यूज़ सेट के अनुरूप बनाने में मदद करता है। इसके अलावा, Inverse Reinforcement Learning (IRL) एक ऐसी technique है जहाँ AI किसी एजेंट के ऑब्जर्व्ड बिहेवियर से उसके अंडरलाइंग गोल्स या रिवार्ड फंक्शन का अनुमान लगाता है। इस तरह, AI इंसानों के एक्शन्स को देखकर उनके इरादों और मूल्यों को समझने की कोशिश करता है, न कि सीधे तौर पर उन्हें कोड में डालने की। ये सभी मेथड्स AI को हमारे इंटेंडेड बिहेवियर के क़रीब लाने के लिए लगातार डेवलप हो रहे हैं।

Ethical Dilemmas और Future की चुनौतियाँ

Bias और Unintended Consequences

Alignment की प्रोसेस में एक बड़ी ethical चुनौती Bias की है। अगर AI को ट्रेन करने वाले डेटा में या फ़ीडबैक देने वाले इंसानों में ही कोई bias है, तो AI सिस्टम भी उसी bias को सीख लेगा। इससे AI ऐसे निर्णय ले सकता है जो कुछ ग्रुप्स के लिए unfair या discriminatory हों। इसके अलावा, AI सिस्टम्स के unintended consequences भी हो सकते हैं। एक अच्छे इरादे से बनाया गया AI भी अगर अपने objective function को ज़्यादा optimize करने के लिए अनचाहे साइड-इफेक्ट्स पैदा करता है, तो यह हमारे मूल्यों के विपरीत हो सकता है। उदाहरण के लिए, अगर AI को ग्लोबल वार्मिंग कम करने का टास्क दिया जाए, तो वह ऐसे कठोर और अमानवीय उपाय सुझा सकता है जो इंसानी जीवन और स्वतंत्रता के लिए खतरा हों।

Superintelligent AI और Control Problem

जैसे-जैसे AI ज़्यादा एडवांस होकर Superintelligence की तरफ बढ़ रहा है, “control problem” की चुनौती और भी गंभीर होती जा रही है। अगर एक AI सिस्टम इंसानों से कहीं ज़्यादा इंटेलिजेंट हो जाता है, तो उसे कंट्रोल करना या उसके बिहेवियर को पूरी तरह से प्रेडिक्ट करना बहुत मुश्किल हो जाएगा। ऐसे में, यह सुनिश्चित करना कि वह हमारे कोर वैल्यूज़ से हमेशा अलाइन रहे, एक existential सवाल बन जाता है। इस प्रॉब्लम को हल करने के लिए multidisciplinary research की आवश्यकता है, जिसमें फिलॉसफी, एथिक्स, सोशल साइंस और कंप्यूटर साइंस के एक्सपर्ट्स मिलकर काम करें ताकि हम एक सुरक्षित और beneficial AI फ़्यूचर बना सकें।

इस आर्टिकल में, हमने AI Safety के एक महत्वपूर्ण पहलू, मानवीय मूल्यों के साथ AI अलाइनमेंट, को गहराई से समझा। हमने देखा कि AI को केवल स्मार्ट बनाना ही पर्याप्त नहीं है, बल्कि उसे हमारे core values और intentions के अनुरूप बनाना भी उतना ही ज़रूरी है। मानवीय मूल्यों को परिभाषित करने की जटिलताओं से लेकर RLHF और Constitutional AI जैसे technical approaches तक, हमने इस चुनौती के कई आयामों को explored किया। Bias, unintended consequences और superintelligent AI के control problem जैसी ethical dilemmas और भविष्य की चुनौतियाँ भी हमने देखीं। यह स्पष्ट है कि AI Alignment एक जटिल, बहुआयामी और निरंतर विकसित होने वाला क्षेत्र है। एक सुरक्षित और सकारात्मक AI फ़्यूचर सुनिश्चित करने के लिए, रिसर्चर्स, पॉलिसीमेकर्स, और आम जनता के बीच निरंतर सहयोग और विचार-विमर्श बेहद आवश्यक है। हमें मिलकर यह सुनिश्चित करना होगा कि AI टेक्नोलॉजी इंसानियत के उज्ज्वल भविष्य का एक आधार बने, न कि किसी अनचाही चुनौती का।