आर्टिफिशियल इंटेलिजेंस (AI) आज की दुनिया का सबसे तेज़ी से बढ़ता और प्रभावशाली क्षेत्र है। AI की दुनिया में, कुछ तकनीकें ऐसी हैं जिन्होंने इसे पूरी तरह बदल दिया है, और इन्हीं में से एक है Deep Learning। Deep Learning की गहराई में जाने पर हमें Neural Networks मिलते हैं, जो AI को इंसानों की तरह सीखने और सोचने की क्षमता देते हैं। और जब बात आती है Natural Language Processing (NLP) और AI के सबसे advanced applications की, तो Transformers आर्किटेक्चर एक गेम-चेंजर साबित हुआ है। इस आर्टिकल में, हम इन सभी महत्वपूर्ण concepts को एक क्रम में समझेंगे, AI के fundamental ideas से लेकर Transformers की क्रांतिकारी तकनीक तक, और जानेंगे कि कैसे इन्होंने modern AI landscape को redefine किया है।

AI और Deep Learning की बुनियाद

आर्टिफिशियल इंटेलिजेंस (AI) एक ऐसा ब्रॉड फ़ील्ड है जहाँ हम मशीनों को इंसानों जैसी इंटेलिजेंस (जैसे सीखना, समस्या हल करना, निर्णय लेना) सिखाने की कोशिश करते हैं। AI की कई शाखाएँ हैं, और उनमें से एक बहुत powerful शाखा है Machine Learning (ML)। ML में, हम मशीनों को explicit programming के बजाय data से सीखने देते हैं।

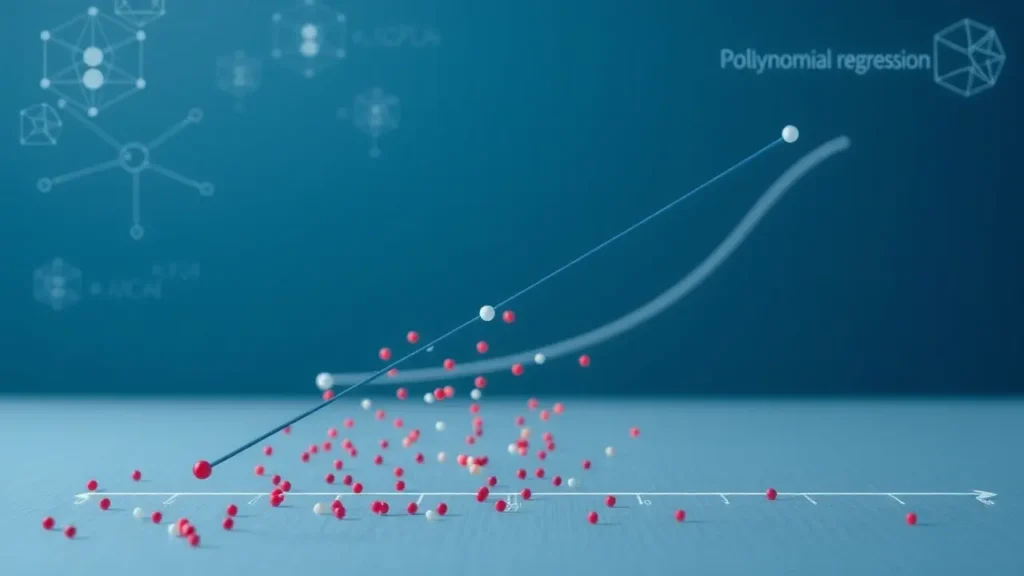

Deep Learning (DL), Machine Learning का ही एक सबसेट है। यह ऐसी तकनीक है जो multiple layers वाले Artificial Neural Networks का उपयोग करके data से सीखती है। पारंपरिक Machine Learning algorithms के विपरीत, Deep Learning models बहुत बड़े और कॉम्प्लेक्स datasets से intricate patterns को सीधे सीख सकते हैं, अक्सर बिना किसी human intervention के features extract किए बिना। इसका मतलब है कि Deep Learning models खुद ही तय कर सकते हैं कि data में क्या महत्वपूर्ण है, जैसे किसी image में edges या shapes को पहचानना, या किसी text में important words को समझना। इसी क्षमता के कारण, Deep Learning ने इमेज रिकॉग्निशन, स्पीच रिकॉग्निशन और Natural Language Processing (NLP) जैसे क्षेत्रों में शानदार सफलता हासिल की है।

Neural Networks: दिमाग की प्रेरणा से

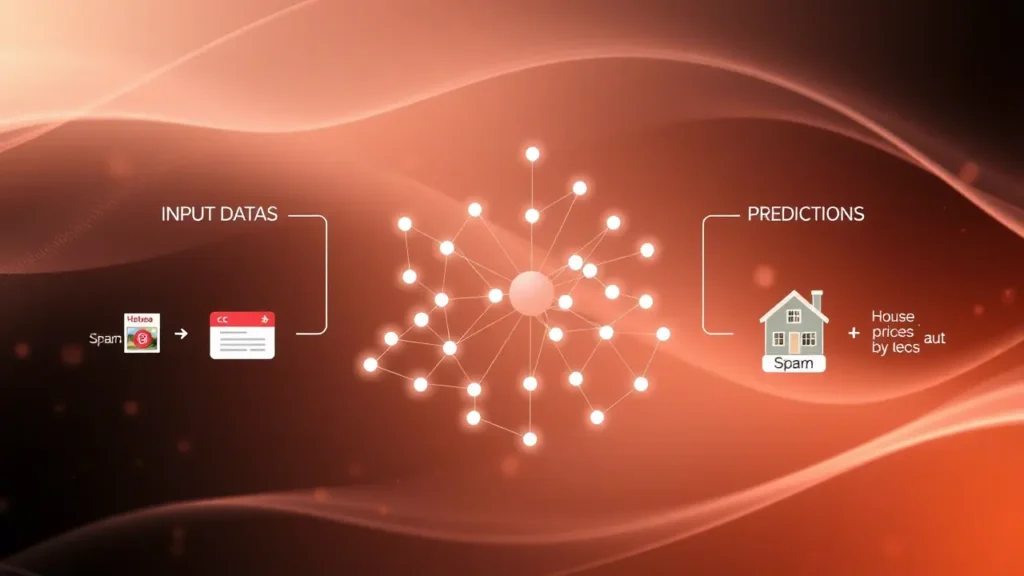

Deep Learning का heart और soul हैं Neural Networks, जिन्हें Artificial Neural Networks (ANNs) भी कहते हैं। ये human brain की संरचना और कार्यप्रणाली से प्रेरित होते हैं। एक Neural Network कई interconnected “neurons” या “nodes” से बना होता है, जो layers में व्यवस्थित होते हैं।

- Input Layer: यह layer data को नेटवर्क में फीड करती है।

- Hidden Layers: ये layers input data पर कॉम्प्लेक्स computations करती हैं। Deep Learning models में कई hidden layers होती हैं, इसीलिए इन्हें “deep” कहा जाता है। हर neuron अपने पिछले layer के neurons से input लेता है, उन पर कुछ mathematical operations करता है, और फिर एक output generate करता है जिसे अगले layer को pass करता है।

- Output Layer: यह layer नेटवर्क का फाइनल प्रेडिक्शन या आउटपुट देती है।

ये neurons weights और biases का उपयोग करके सीखते हैं, जो training के दौरान एडजस्ट होते रहते हैं। एक Activation Function हर neuron के आउटपुट को निर्धारित करती है। जब नेटवर्क को training data दिया जाता है, तो यह प्रेडिक्शन करता है, और यदि प्रेडिक्शन गलत होता है, तो backpropagation नामक प्रक्रिया का उपयोग करके weights और biases को एडजस्ट किया जाता है ताकि अगले प्रेडिक्शन बेहतर हों। यह iterative process Neural Networks को data से सीखने और कॉम्प्लेक्स प्रॉब्लम्स को हल करने में सक्षम बनाता है।

Traditional Neural Networks से आगे: Challenges और Solutions

Neural Networks की शक्ति असीमित है, लेकिन कुछ खास तरह के data, जैसे sequential data (text, audio, time series), के लिए पारंपरिक Feedforward Neural Networks की कुछ सीमाएँ थीं। इन चुनौतियों को हल करने के लिए Recurrent Neural Networks (RNNs) और Long Short-Term Memory (LSTM) networks जैसे आर्किटेक्चर्स विकसित किए गए। RNNs और LSTMs sequentially data process करते हैं, यानी वे एक समय में एक step आगे बढ़ते हुए पिछले steps की जानकारी को “याद” रखते हैं।

हालांकि, RNNs और LSTMs के साथ भी अपनी चुनौतियाँ थीं:

- Long-Range Dependencies: बहुत लंबी sequences में, RNNs को शुरुआत की जानकारी को अंत तक “याद” रखने में दिक्कत आती थी, जिसे vanishing gradient problem भी कहते हैं।

- Parallelization का अभाव: चूंकि वे sequential होते हैं, RNNs को parallel तरीके से train करना मुश्किल था। इसका मतलब है कि बड़े datasets पर training में बहुत समय लगता था।

इन सीमाओं ने रिसर्चर्स को एक ऐसे आर्किटेक्चर की तलाश करने पर मजबूर किया जो long sequences को अधिक कुशलता से हैंडल कर सके और parallel processing की अनुमति दे सके। यहीं पर Transformers का उदय हुआ, जिसने इन सभी चुनौतियों का एक revolutionary solution पेश किया।

Transformers: NLP में एक क्रांतिकारी बदलाव

2017 में “Attention Is All You Need” पेपर के साथ Google Brain द्वारा पेश किया गया Transformer आर्किटेक्चर, Natural Language Processing (NLP) के क्षेत्र में एक गेम-चेंजर साबित हुआ। इसने RNNs और LSTMs की sequential nature को पूरी तरह से हटा दिया और एक नई अवधारणा पेश की: Attention Mechanism।

Transformer की मुख्य खासियत Self-Attention Mechanism है। यह मैकेनिज़्म मॉडल को एक ही sequence के अंदर के अलग-अलग शब्दों के बीच संबंधों को समझने में मदद करता है। उदाहरण के लिए, “The animal didn’t cross the street because it was too tired” वाक्य में, “it” शब्द का संबंध “animal” से है। Self-Attention मॉडल को यह “ध्यान” देने की अनुमति देता है कि वाक्य में कौन से शब्द दूसरे शब्दों के लिए सबसे महत्वपूर्ण हैं, चाहे वे कितने भी दूर क्यों न हों। यह long-range dependencies की समस्या को प्रभावी ढंग से हल करता है।

Transformer आर्किटेक्चर को Encoder-Decoder संरचना में व्यवस्थित किया गया है:

- Encoder: यह input sequence को process करता है और contextually rich representations (meaningful numerical representations) बनाता है। इसमें multi-head self-attention और feed-forward layers होती हैं।

- Decoder: यह encoder के आउटपुट और पिछले generated tokens का उपयोग करके आउटपुट sequence generate करता है। इसमें भी multi-head self-attention (masked self-attention) और encoder-decoder attention layers होती हैं।

सबसे महत्वपूर्ण बात यह है कि Self-Attention Mechanism की वजह से Transformer layers को parallel में process किया जा सकता है। यह training time को dramatically कम कर देता है और बहुत बड़े datasets पर training को संभव बनाता है। इसी वजह से BERT, GPT-3, T5 जैसे powerful models बन पाए हैं, जिन्होंने मशीन ट्रांसलेशन, टेक्स्ट summarization, क्वेश्चन-आंसरिंग और टेक्स्ट generation जैसे NLP tasks में रिकॉर्ड-तोड़ प्रदर्शन किया है। Transformer ने न केवल NLP को, बल्कि कंप्यूटर विजन जैसे अन्य AI क्षेत्रों को भी प्रभावित किया है।

AI के इस सफर में हमने देखा कि कैसे Core AI Techniques से शुरुआत होकर Deep Learning ने एक नई दिशा दी। Neural Networks ने मशीनों को सीखने की शक्ति दी, और उनकी सीमाओं को पार करते हुए Transformers ने एक revolutionary breakthrough प्रदान किया। Self-Attention Mechanism की बदौलत Transformers ने Natural Language Processing (NLP) में क्रांति ला दी है, जिससे AI मॉडल्स अब इंसानों की भाषा को पहले से कहीं बेहतर तरीके से समझ और generate कर पा रहे हैं। parallel processing की क्षमता ने बड़े और अधिक शक्तिशाली मॉडल्स को train करना संभव बना दिया है, जिससे AI की क्षमताएँ लगातार बढ़ रही हैं। यह यात्रा हमें दिखाती है कि कैसे fundamental ideas लगातार विकसित होते रहते हैं, जिससे तकनीक में अद्भुत प्रगति होती है। भविष्य में AI की ये तकनीकें हमारे जीवन को और भी अधिक गहराई से प्रभावित करेंगी, नए innovations और अनुप्रयोगों का मार्ग प्रशस्त करेंगी।