Unsupervised Learning में Dimensionality Reduction का उपयोग बिना लेबल वाले डेटा (Unlabeled Data) में फीचर्स (Features) की संख्या को कम करने के लिए किया जाता है। यह तकनीक डेटा की जटिलता (Complexity) को कम करती है और अंतर्निहित संरचना (Underlying Structure) को समझने में मदद करती है। यहां कुछ प्रमुख तकनीकें और उनके विवरण दिए गए हैं:

1. Unsupervised Dimensionality Reduction क्या है?

- परिभाषा: यह एक ऐसी प्रक्रिया है जो बिना लेबल वाले डेटा (Unlabeled Data) में फीचर्स की संख्या को कम करती है, जबकि डेटा की महत्वपूर्ण जानकारी (Important Information) को बरकरार रखती है।

- उद्देश्य:

- डेटा को विज़ुअलाइज़ (Visualize) करना।

- नॉइज़ (Noise) और अनावश्यक फीचर्स (Redundant Features) को हटाना।

- मॉडल की परफॉर्मेंस (Model Performance) को बेहतर करना।

2. प्रमुख तकनीकें (Key Techniques)

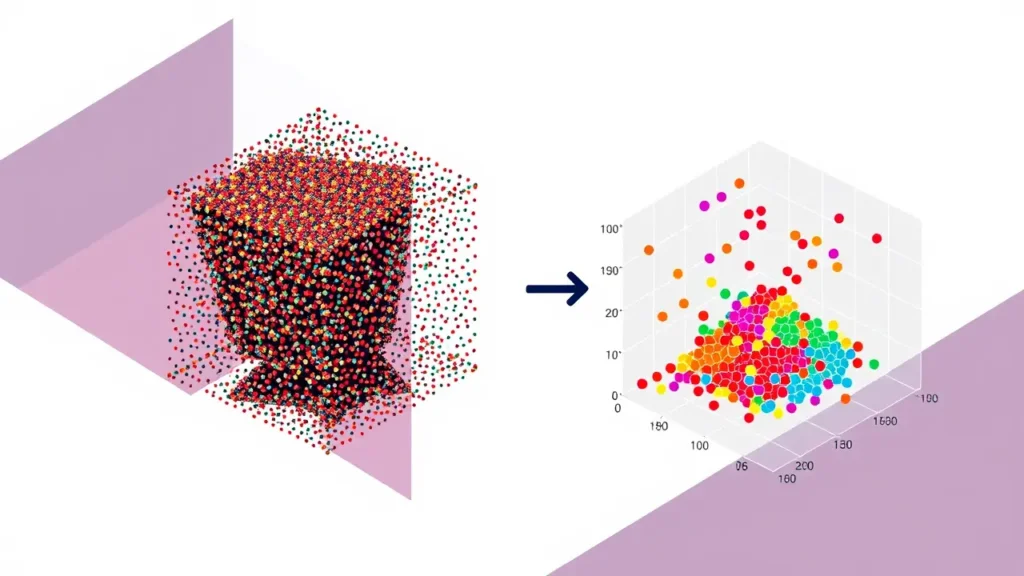

2.1 Principal Component Analysis (PCA)

- कैसे काम करता है?

PCA डेटा को एक नए स्पेस (Space) में प्रोजेक्ट करता है, जहां वेरिएंस (Variance) अधिकतम होता है। यह नए अक्ष (Axes) बनाता है, जिन्हें प्रिंसिपल कंपोनेंट्स (Principal Components) कहते हैं। - उपयोग:

- इमेज प्रोसेसिंग (Image Compression)।

- जीन एक्सप्रेशन डेटा (Gene Expression Data) का विश्लेषण।

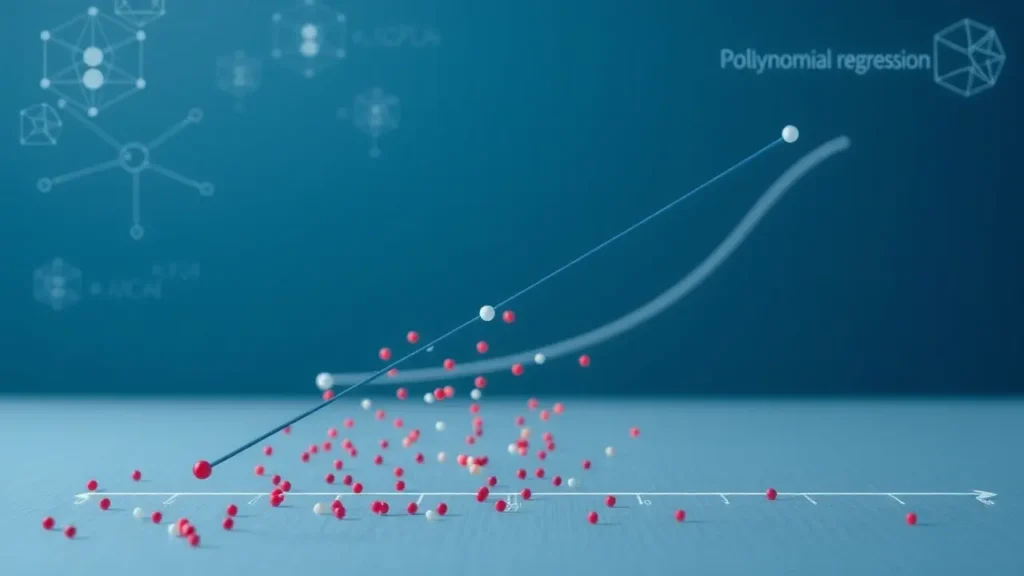

2.2 t-SNE (t-Distributed Stochastic Neighbor Embedding)

- कैसे काम करता है?

यह नॉन-लीनियर (Non-Linear) तकनीक है जो हाई-डायमेंशनल डेटा को 2D या 3D में प्रोजेक्ट करती है, ताकि समान डेटा पॉइंट्स (Similar Data Points) पास-पास दिखें। - उपयोग:

- MNIST डेटासेट (हस्तलिखित अंक) को विज़ुअलाइज़ करना।

- टेक्स्ट डेटा (Text Data) की क्लस्टरिंग (Clustering)।

2.3 LLE (Locally Linear Embedding)

- कैसे काम करता है?

यह डेटा के स्थानीय संबंधों (Local Relationships) को बनाए रखते हुए लो-डायमेंशनल स्पेस (Low-Dimensional Space) में मैप करता है। - उपयोग:

- स्विस रोल (Swiss Roll) जैसे कॉम्प्लेक्स डेटा को विज़ुअलाइज़ करना।

2.4 Autoencoders (ऑटोएन्कोडर्स)

- कैसे काम करता है?

यह एक न्यूरल नेटवर्क (Neural Network) आर्किटेक्चर है जो डेटा को कम डायमेंशनल स्पेस (Latent Space) में एन्कोड (Encode) करता है और फिर डीकोड (Decode) करके रिकन्स्ट्रक्ट (Reconstruct) करता है। - उपयोग:

- इमेज डीनॉइज़िंग (Image Denoising)।

- एनोमली डिटेक्शन (Anomaly Detection)।

3. अन्य तकनीकें (Other Techniques)

- ICA (Independent Component Analysis): सिग्नल प्रोसेसिंग में उपयोगी, जो डेटा को सांख्यिकीय रूप से स्वतंत्र (Statistically Independent) कंपोनेंट्स में अलग करता है।

- UMAP (Uniform Manifold Approximation and Projection): t-SNE की तरह, लेकिन ग्लोबल स्ट्रक्चर (Global Structure) को बेहतर बनाए रखता है।

4. उपयोग के उदाहरण (Applications)

- इमेज कंप्रेशन (Image Compression): PCA का उपयोग करके इमेज के आकार को कम करना।

- डेटा विज़ुअलाइज़ेशन (Data Visualization): t-SNE द्वारा हाई-डायमेंशनल डेटा को 2D में दिखाना।

- रिकमेंडेशन सिस्टम (Recommendation Systems): उपयोगकर्ता प्राथमिकताओं (User Preferences) को कम डायमेंशन में प्रस्तुत करना।

- एनोमली डिटेक्शन (Anomaly Detection): Autoencoders द्वारा असामान्य डेटा पॉइंट्स की पहचान करना।

5. फायदे (Advantages)

- नॉइज़ रिडक्शन (Noise Reduction): अनावश्यक फीचर्स हटाने से डेटा की गुणवत्ता (Quality) बढ़ती है।

- कम्प्यूटेशनल एफिशिएंसी (Computational Efficiency): कम फीचर्स होने से मॉडल तेजी से ट्रेन होता है।

- विज़ुअलाइज़ेशन (Visualization): 2D/3D में डेटा को समझना आसान होता है।

6. सीमाएं (Limitations)

- जानकारी का नुकसान (Information Loss): फीचर्स कम करने से महत्वपूर्ण जानकारी खो सकती है।

- इंटरप्रेटेशन (Interpretation): PCA जैसी तकनीकों में नए कंपोनेंट्स (Components) को समझना मुश्किल हो सकता है।

- पैरामीटर ट्यूनिंग (Parameter Tuning): t-SNE और UMAP जैसी तकनीकों में पैरामीटर्स को ट्यून करना जटिल है।

7. निष्कर्ष (Conclusion)

Unsupervised Dimensionality Reduction डेटा साइंस का एक महत्वपूर्ण टूल है जो बिना लेबल वाले डेटा को सरल और समझने योग्य बनाता है। PCA, t-SNE, और Autoencoders जैसी तकनीकें विभिन्न प्रकार की समस्याओं (जैसे: विज़ुअलाइज़ेशन, कंप्रेशन) के लिए उपयोगी हैं। हालांकि, इनका उपयोग करते समय जानकारी के नुकसान और इंटरप्रेटेशन की समस्याओं का ध्यान रखना जरूरी है। 🛠️🔍