आर्टिफिशियल इंटेलिजेंस (AI) की दुनिया लगातार विकसित हो रही है, और इसके मूल में कुछ fundamental techniques हैं जो इस क्रांति को शक्ति प्रदान करती हैं। इन तकनीकों में, डीप लर्निंग (Deep Learning – DL) एक महत्वपूर्ण स्थान रखता है, जो इंसानी दिमाग की संरचना से प्रेरित होकर जटिल पैटर्न को समझने और सीखने की क्षमता रखता है। डीप लर्निंग के भीतर, न्यूरल नेटवर्क्स (Neural Networks) इसके बिल्डिंग ब्लॉक्स हैं, और इन्हीं न्यूरल नेटवर्क्स का एक बहुत ही powerful और foundational प्रकार है मल्टी-लेयर परसेप्ट्रॉन (Multi-Layer Perceptrons – MLPs)। यह आर्टिकल आपको MLPs की दुनिया में गहराई से ले जाएगा, उनकी कार्यप्रणाली, महत्व और विभिन्न AI एप्लीकेशन्स में उनकी भूमिका को समझाएगा।

डीप लर्निंग और न्यूरल नेटवर्क्स की बुनियाद

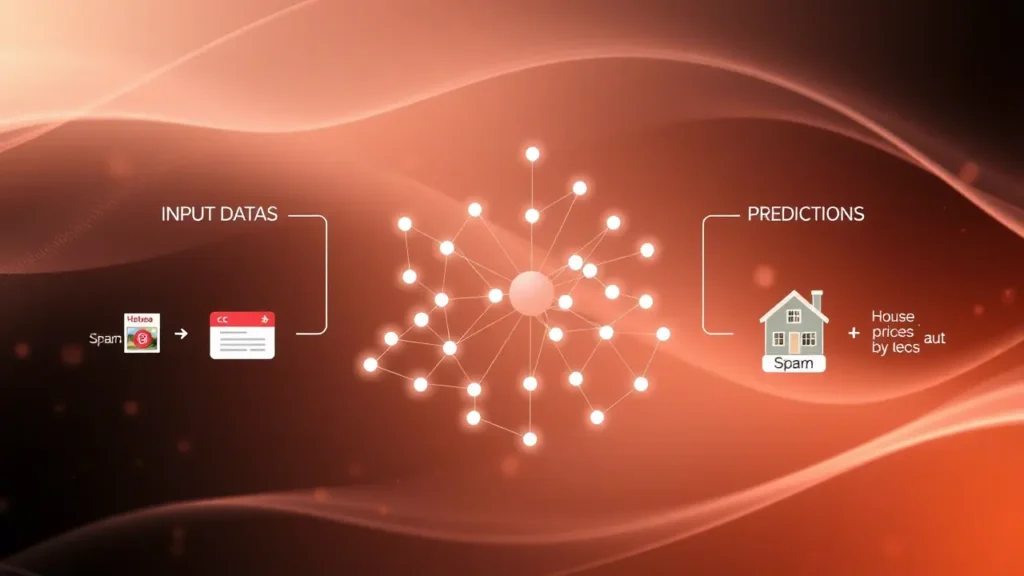

डीप लर्निंग, मशीन लर्निंग का एक उपक्षेत्र है जो आर्टिफिशियल न्यूरल नेटवर्क्स (ANNs) का उपयोग करता है। यह मानव मस्तिष्क की संरचना और कार्यप्रणाली से प्रेरित है, खासकर न्यूरॉन्स के एक-दूसरे से जुड़ने के तरीके से। डीप लर्निंग मॉडल्स को डेटा से सीधे सीखने के लिए डिज़ाइन किया गया है, जिसमें बहुत सारे लेयर्स होते हैं जो डेटा के abstract representations सीखते हैं।

न्यूरल नेटवर्क्स ही डीप लर्निंग के आधार हैं। एक न्यूरल नेटवर्क में कई इंटरकनेक्टेड नोड्स या “न्यूरॉन्स” होते हैं जो लेयर्स में व्यवस्थित होते हैं। ये लेयर्स आमतौर पर तीन प्रकार की होती हैं:

- इनपुट लेयर (Input Layer): यह डेटा को नेटवर्क में फीड करती है।

- हिडन लेयर्स (Hidden Layers): ये इनपुट से complex patterns और features निकालते हैं। एक डीप लर्निंग मॉडल में कई हिडन लेयर्स होती हैं।

- आउटपुट लेयर (Output Layer): यह नेटवर्क के अंतिम परिणाम या prediction को प्रस्तुत करती है।

हर न्यूरॉन दूसरे न्यूरॉन से जुड़े होते हैं, और इन कनेक्शनों को weights द्वारा दर्शाया जाता है। ये weights तय करते हैं कि एक न्यूरॉन से दूसरे न्यूरॉन तक सिग्नल कितना मजबूत या कमजोर जाएगा।

मल्टी-लेयर परसेप्ट्रॉन (MLPs) क्या हैं?

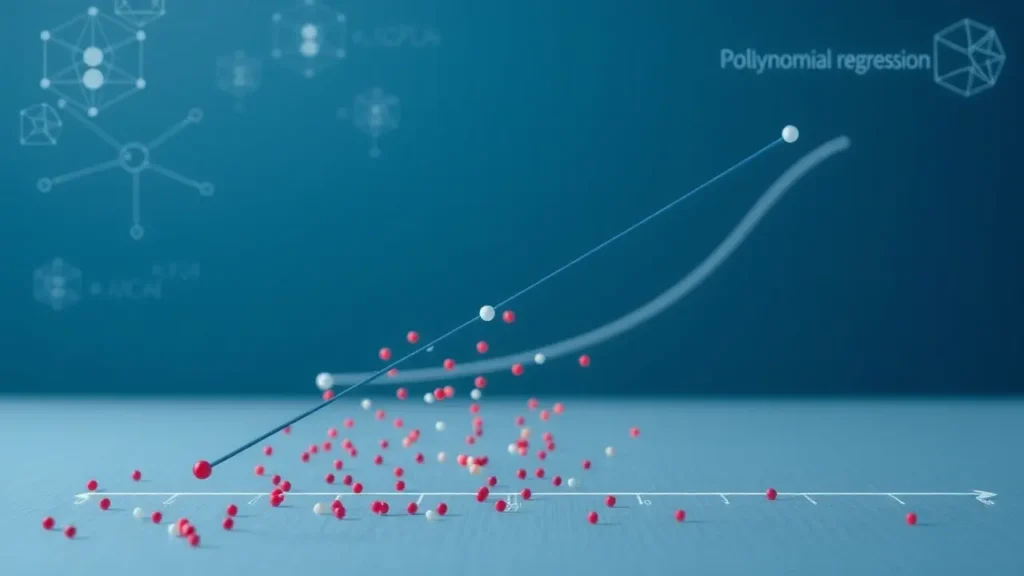

मल्टी-लेयर परसेप्ट्रॉन (MLP) एक प्रकार का फीडफॉरवर्ड आर्टिफिशियल न्यूरल नेटवर्क है। “मल्टी-लेयर” शब्द का अर्थ है कि इसमें एक इनपुट लेयर, एक आउटपुट लेयर और कम से कम एक या अधिक हिडन लेयर्स होती हैं। यह इसे सिंगल-लेयर परसेप्ट्रॉन से अलग बनाता है, जो केवल linear separable समस्याओं को ही हल कर सकता है। MLP अपनी हिडन लेयर्स के कारण nonlinear separable समस्याओं को भी प्रभावी ढंग से हल कर सकता है, जो इसे classification, regression और pattern recognition जैसे कई कार्यों के लिए उपयोगी बनाता है।

एक MLP की संरचना में शामिल हैं:

- न्यूरॉन्स (Neurons): ये नेटवर्क की प्रोसेसिंग यूनिट्स हैं। प्रत्येक न्यूरॉन इनपुट लेता है, एक ऑपरेशन करता है, और आउटपुट देता है।

- कनेक्शंस (Connections) और वेट्स (Weights): न्यूरॉन्स के बीच के संबंध। प्रत्येक कनेक्शन का एक weight होता है, जो इनपुट के महत्व को दर्शाता है।

- एक्टिवेशन फ़ंक्शंस (Activation Functions): प्रत्येक न्यूरॉन के आउटपुट पर एक नॉन-लीनियर transformation लागू करता है, जिससे नेटवर्क जटिल patterns सीख पाता है। Sigmoid, ReLU (Rectified Linear Unit), और Tanh कुछ सामान्य एक्टिवेशन फंक्शन्स हैं।

MLPs की आंतरिक कार्यप्रणाली और प्रशिक्षण

MLPs दो मुख्य चरणों में काम करते हैं: फॉरवर्ड प्रोपेगेशन (Forward Propagation) और बैकप्रोपेगेशन (Backpropagation)।

फॉरवर्ड प्रोपेगेशन:

इस चरण में, इनपुट डेटा इनपुट लेयर से हिडन लेयर्स के माध्यम से आउटपुट लेयर तक “आगे” बढ़ता है।

- प्रत्येक न्यूरॉन पिछले लेयर के सभी न्यूरॉन्स से इनपुट प्राप्त करता है।

- यह इनपुट को अपने संबंधित weights से गुणा करता है और सभी weighted inputs को sum करता है।

- एक bias टर्म भी इस sum में जोड़ा जाता है।

- परिणामी sum पर एक एक्टिवेशन फ़ंक्शन लागू किया जाता है, जो न्यूरॉन का आउटपुट बन जाता है।

- यह प्रक्रिया अगली लेयर के लिए इनपुट बन जाती है, और अंततः आउटपुट लेयर तक पहुँच जाती है।

बैकप्रोपेगेशन और प्रशिक्षण:

MLP का सीखना फॉरवर्ड प्रोपेगेशन द्वारा दिए गए आउटपुट की सटीकता पर आधारित होता है।

- नेटवर्क के आउटपुट की तुलना वास्तविक आउटपुट (जिसे ground truth कहा जाता है) से की जाती है, और त्रुटि (error) की गणना की जाती है।

- बैकप्रोपेगेशन एल्गोरिथम इस त्रुटि को नेटवर्क में “पीछे” की ओर फैलाता है, आउटपुट लेयर से इनपुट लेयर तक।

- यह एल्गोरिथम कैलकुलेट करता है कि प्रत्येक weight और bias ने कुल त्रुटि में कितना योगदान दिया।

- फिर, ग्रेडिएंट डिसेंट (Gradient Descent) जैसी ऑप्टिमाइजेशन तकनीकों का उपयोग करके, weights और biases को इस तरह से adjust किया जाता है जिससे त्रुटि कम हो।

यह फॉरवर्ड और बैकवर्ड पास की iterative प्रक्रिया तब तक दोहराई जाती है जब तक नेटवर्क पर्याप्त रूप से सीख नहीं लेता और त्रुटि एक acceptable स्तर तक कम नहीं हो जाती।

MLPs के फायदे और सीमाएं

मल्टी-लेयर परसेप्ट्रॉन, अपनी सरलता और शक्ति के बावजूद, कुछ फायदे और सीमाओं के साथ आते हैं।

फायदे:

- जटिलता को संभालना: MLPs nonlinear डेटा से जटिल संबंध और पैटर्न सीखने में सक्षम होते हैं, जो उन्हें classification और regression जैसे कार्यों के लिए बहुमुखी बनाते हैं।

- फाउंडेशनल: ये कई advanced neural network architectures, जैसे Convolutional Neural Networks (CNNs) और Recurrent Neural Networks (RNNs) के लिए एक मौलिक बिल्डिंग ब्लॉक के रूप में कार्य करते हैं।

- लचीलापन: हिडन लेयर्स की संख्या और प्रत्येक लेयर में न्यूरॉन्स की संख्या को Adjust करके विभिन्न प्रकार की समस्याओं को हल करने के लिए उन्हें finely tuned किया जा सकता है।

- एल्गोरिथम की अच्छी समझ: बैकप्रोपेगेशन एल्गोरिथम को अच्छी तरह से समझा गया है और यह न्यूरल नेटवर्क को प्रभावी ढंग से प्रशिक्षित करने में सक्षम बनाता है।

सीमाएं:

- कम्प्यूटेशनल लागत: बड़े डेटासेट और कई हिडन लेयर्स वाले गहरे MLPs को प्रशिक्षित करने के लिए महत्वपूर्ण कम्प्यूटेशनल रिसोर्सेज और समय की आवश्यकता हो सकती है।

- ओवरफिटिंग (Overfitting): यदि मॉडल बहुत जटिल है और प्रशिक्षण डेटा छोटा है, तो MLP प्रशिक्षण डेटा पर ओवरफिट कर सकता है, जिसका अर्थ है कि यह नए, अनदेखे डेटा पर खराब प्रदर्शन करेगा।

- ग्रेडिएंट की समस्या: बहुत गहरे नेटवर्क में, vanishing gradients (जहां ग्रेडिएंट्स बहुत छोटे हो जाते हैं, जिससे weights अपडेट नहीं होते) या exploding gradients (जहां ग्रेडिएंट्स बहुत बड़े हो जाते हैं, जिससे weights अस्थिर हो जाते हैं) की समस्या हो सकती है।

- ब्लैक बॉक्स (Black Box) प्रकृति: MLPs की internal workings को समझना अक्सर मुश्किल होता है, जिससे यह व्याख्या करना मुश्किल हो जाता है कि मॉडल ने कोई विशेष निर्णय क्यों लिया।

- विशेष डेटा प्रकारों के लिए नहीं: इमेज (CNNs के लिए बेहतर) या सीक्वेंशियल डेटा (RNNs के लिए बेहतर) जैसे विशेष प्रकार के डेटा के लिए, MLPs उतने प्रभावी नहीं होते हैं जितने कि specialized architectures।

मल्टी-लेयर परसेप्ट्रॉन (MLPs) आर्टिफिशियल इंटेलिजेंस और डीप लर्निंग के क्षेत्र में एक मूलभूत और शक्तिशाली अवधारणा हैं। हमने देखा कि कैसे वे न्यूरल नेटवर्क्स की नींव रखते हैं, जो मानव मस्तिष्क की सीखने की क्षमता से प्रेरित हैं। MLPs अपनी हिडन लेयर्स और नॉन-लीनियर एक्टिवेशन फंक्शन्स के कारण जटिल, नॉन-लीनियर पैटर्न को सीखने में सक्षम होते हैं। फॉरवर्ड प्रोपेगेशन और बैकप्रोपेगेशन के माध्यम से उनका प्रशिक्षण उन्हें डेटा से गलतियों को सीखकर अपने वेट्स और बायसेस को एडजस्ट करने की अनुमति देता है। हालांकि नए और अधिक विशेषीकृत आर्किटेक्चर जैसे CNNs और RNNs कुछ विशिष्ट कार्यों में बेहतर प्रदर्शन कर सकते हैं, MLPs कई सामान्य AI समस्याओं, जैसे क्लासिफिकेशन और रिग्रेशन के लिए एक मजबूत और विश्वसनीय समाधान बने हुए हैं। AI की दुनिया में आगे बढ़ने के लिए MLPs की गहरी समझ होना आवश्यक है।