आर्टिफिशियल इंटेलिजेंस (AI) हमारे जीवन के हर पहलू को बदल रहा है, लेकिन जैसे-जैसे AI सिस्टम अधिक complex होते जा रहे हैं, वैसे-वैसे उन्हें समझना मुश्किल होता जा रहा है। इसी समस्या को हल करने के लिए Explainable AI (XAI) एक महत्वपूर्ण क्षेत्र के रूप में उभरा है। XAI का मुख्य उद्देश्य AI मॉडल्स को अधिक transparent, interpretable और understandable बनाना है। इस लेख में, हम XAI के एक महत्वपूर्ण पहलू पर गहराई से चर्चा करेंगे, जिसे Model Transparency कहा जाता है। हम समझेंगे कि मॉडल ट्रांसपेरेंसी क्या है, इसकी क्या ज़रूरत है, इसे कैसे हासिल किया जा सकता है और इससे जुड़ी चुनौतियाँ क्या हैं। हमारा लक्ष्य AI सिस्टम में trust और accountability को बढ़ाना है, ताकि हम AI की पूरी क्षमता का सुरक्षित और प्रभावी ढंग से उपयोग कर सकें।

Model Transparency क्या है?

AI के संदर्भ में, Model Transparency का मतलब है एक AI मॉडल की आंतरिक कार्यप्रणाली (internal workings) और उसके decision-making process को कितनी आसानी से समझा जा सकता है। यह सिर्फ यह जानने से कहीं ज़्यादा है कि मॉडल किस एल्गोरिथम का उपयोग करता है। यह इस बात को समझने के बारे में है कि मॉडल किसी विशेष इनपुट के लिए एक निश्चित आउटपुट या prediction क्यों देता है। सरल शब्दों में, जब हम एक AI मॉडल को transparent कहते हैं, तो हमारा मतलब है कि हम यह बता सकते हैं कि उसने किसी specific decision तक पहुँचने के लिए किस डेटा, फीचर्स और लॉजिक का इस्तेमाल किया।

उदाहरण के लिए, एक simple linear regression model को आमतौर पर transparent माना जाता है क्योंकि हम coefficients को देखकर सीधे समझ सकते हैं कि प्रत्येक feature आउटपुट को कैसे प्रभावित करता है। इसके विपरीत, एक deep neural network को अक्सर “black box” मॉडल कहा जाता है क्योंकि इसकी लाखों interconnected परतें (layers) और non-linear transformations इतनी जटिल होती हैं कि यह समझना लगभग असंभव हो जाता है कि एक विशेष इनपुट ने अंतिम आउटपुट को कैसे प्रेरित किया। Model Transparency का लक्ष्य इसी “black box” समस्या को दूर करना है, ताकि यूजर्स, डेवलपर्स और रेगुलेटर AI के निर्णयों को समझ सकें और उन पर भरोसा कर सकें।

Model Transparency की ज़रूरत क्यों है?

आज के डिजिटल युग में, जहाँ AI निर्णय लेने में एक बड़ी भूमिका निभा रहा है, वहाँ Model Transparency की ज़रूरत कई कारणों से अत्यंत महत्वपूर्ण है।

- Trust और Adoption (विश्वास और अपनाना): जब AI सिस्टम के निर्णय अस्पष्ट होते हैं, तो उन पर भरोसा करना मुश्किल होता है। खासकर स्वास्थ्य सेवा, वित्त या न्याय जैसे संवेदनशील क्षेत्रों में, लोगों को यह जानने का अधिकार है कि AI उनके बारे में निर्णय कैसे ले रहा है। Transparency से उपयोगकर्ताओं और stakeholders का AI पर विश्वास बढ़ता है, जिससे इसकी व्यापक स्वीकृति और उपयोग को बढ़ावा मिलता है।

- Debugging और Improvement (त्रुटियों का पता लगाना और सुधार): एक non-transparent मॉडल में त्रुटियों या bias का पता लगाना बहुत मुश्किल हो सकता है। यदि हम नहीं जानते कि मॉडल गलत निर्णय क्यों ले रहा है, तो हम इसे ठीक भी नहीं कर सकते। Transparency डेवलपर्स को मॉडल की कमियों को समझने, उन्हें डीबग करने और इसकी performance को लगातार बेहतर बनाने में मदद करती है।

- Fairness और Ethics (निष्पक्षता और नैतिकता): AI मॉडल्स अनजाने में training data में मौजूद biases को सीख सकते हैं और पूर्वाग्रही निर्णय ले सकते हैं, जिससे सामाजिक असमानताएँ बढ़ सकती हैं। Model Transparency हमें यह पहचानने में सक्षम बनाती है कि मॉडल कब और क्यों unfair या discriminatory निर्णय ले रहा है, जिससे हम इन biases को दूर करने के लिए कदम उठा सकें और नैतिक AI सिस्टम का निर्माण कर सकें।

- Regulatory Compliance (नियामक अनुपालन): कई देशों में, जैसे कि यूरोप का GDPR, व्यक्तियों को AI द्वारा लिए गए निर्णयों की “explanation का अधिकार” (right to explanation) प्रदान करता है। Model Transparency इन कानूनी और नियामक आवश्यकताओं को पूरा करने के लिए आवश्यक है, खासकर उन AI-संचालित प्रणालियों के लिए जो व्यक्तिगत डेटा का उपयोग करती हैं।

- Scientific Discovery और Learning (वैज्ञानिक खोज और सीखना): कुछ क्षेत्रों में, AI का उपयोग जटिल वैज्ञानिक घटनाओं को समझने के लिए किया जाता है। एक transparent मॉडल न केवल भविष्यवाणियाँ करता है बल्कि यह भी बता सकता है कि किन कारकों का सबसे अधिक प्रभाव पड़ता है, जिससे शोधकर्ताओं को नई अंतर्दृष्टि प्राप्त होती है।

Model Transparency कैसे हासिल करें?

Model Transparency को हासिल करने के लिए कई approaches और techniques उपलब्ध हैं। इन्हें मोटे तौर पर दो मुख्य श्रेणियों में बांटा जा सकता है:

-

Intrinsic Transparency (अंतर्निहित पारदर्शिता):

यह उन मॉडल्स को संदर्भित करता है जो अपनी प्रकृति से ही समझने में आसान होते हैं। ये मॉडल्स अक्सर simpler होते हैं और उनके निर्णय लेने के तर्क को सीधे देखा जा सकता है।

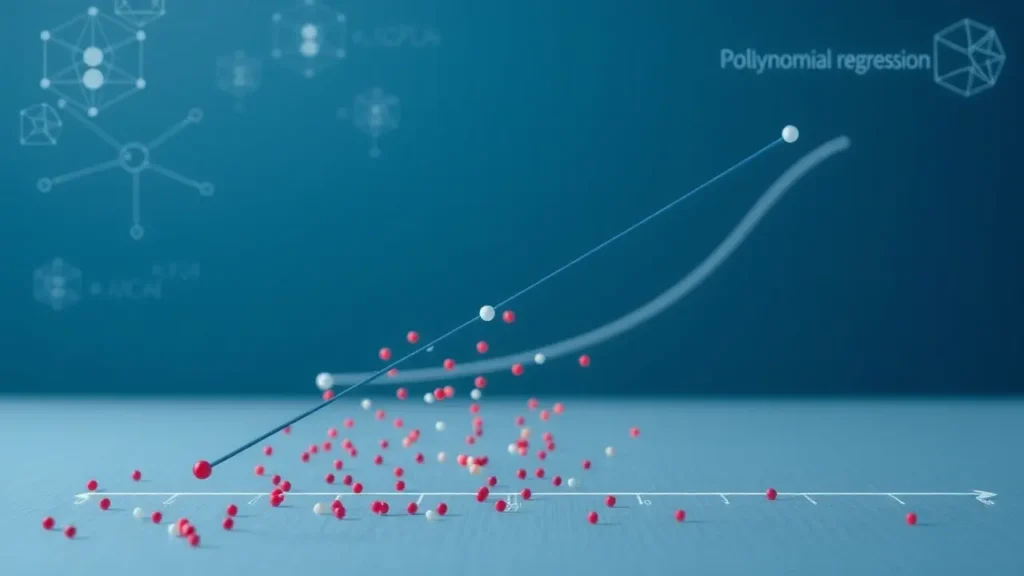

- Linear Regression (रैखिक प्रतिगमन): यह मॉडल एक सीधी रेखा का उपयोग करके वैरियेबल्स के बीच संबंध को दिखाता है। प्रत्येक फीचर का प्रभाव उसके coefficient से सीधे समझा जा सकता है।

- Decision Trees (निर्णय वृक्ष): ये एक फ़्लोचार्ट जैसी संरचना का उपयोग करते हैं, जहाँ प्रत्येक नोड एक प्रश्न का प्रतिनिधित्व करता है और प्रत्येक शाखा एक संभावित उत्तर का। अंतिम निर्णय तक पहुँचने के लिए जिन नियमों का पालन किया गया, उन्हें आसानी से देखा जा सकता है।

- Rule-Based Systems (नियम-आधारित सिस्टम): ये पूर्व-निर्धारित “if-then” नियमों के सेट पर काम करते हैं। इन नियमों को देखकर मॉडल का व्यवहार स्पष्ट रूप से समझा जा सकता है।

हालांकि ये मॉडल transparent होते हैं, लेकिन ये अक्सर बहुत जटिल डेटासेट पर high-performance प्राप्त करने में struggle करते हैं।

-

Post-hoc Explanations (पश्चात-स्पष्टीकरण):

यह उन तकनीकों को संदर्भित करता है जो एक जटिल “black box” मॉडल द्वारा भविष्यवाणी करने के बाद उसके निर्णय को समझाने का प्रयास करती हैं। ये तकनीकें मॉडल की आंतरिक कार्यप्रणाली को सीधे नहीं बदलती हैं बल्कि उसके व्यवहार का विश्लेषण करके explanations generate करती हैं।

- LIME (Local Interpretable Model-agnostic Explanations): LIME किसी एक specific prediction को explain करने पर केंद्रित है। यह original मॉडल के व्यवहार का अनुमान लगाने के लिए उस prediction के आसपास के डेटा पर एक simple, interpretable मॉडल (जैसे लीनियर मॉडल) को train करता है। यह हमें बताता है कि specific instance के लिए मॉडल ने किन फीचर्स को सबसे महत्वपूर्ण माना।

- SHAP (SHapley Additive exPlanations): SHAP game theory पर आधारित है और यह बताता है कि एक मॉडल की भविष्यवाणी में प्रत्येक feature का कितना योगदान है। यह प्रत्येक feature को “पुरस्कार” के रूप में देखता है और Shapley values का उपयोग करके प्रत्येक feature को उसके contribution के आधार पर एक मान निर्दिष्ट करता है, जिससे global और local दोनों तरह की explanations मिलती हैं।

- Feature Importance (फीचर महत्व): यह बताता है कि मॉडल की overall performance के लिए कौन से फीचर्स सबसे महत्वपूर्ण हैं।

- Partial Dependence Plots (PDPs) और Individual Conditional Expectation (ICE) plots: ये विज़ुअलाइज़ेशन हमें दिखाते हैं कि एक या दो फीचर्स में बदलाव मॉडल के आउटपुट को कैसे प्रभावित करते हैं।

Post-hoc techniques हमें जटिल, high-performance मॉडल्स की व्याख्या करने में मदद करती हैं, लेकिन उनके explanations खुद जटिल या पूरी तरह से सटीक नहीं हो सकते हैं।

Model Transparency की चुनौतियाँ और भविष्य

Model Transparency को हासिल करना और उसे प्रभावी ढंग से उपयोग करना कई चुनौतियों से भरा है, लेकिन इसके भविष्य में अपार संभावनाएँ भी हैं।

-

चुनौतियाँ:

- Performance-Interpretability Trade-off: अक्सर, अधिक interpretable मॉडल्स की performance जटिल, non-transparent मॉडल्स की तुलना में कम होती है। हमें ऐसे तरीके खोजने होंगे जो दोनों के बीच संतुलन बना सकें।

- Complexity of Explanations: कभी-कभी, explanations खुद इतनी जटिल हो सकती हैं कि उन्हें समझना मुश्किल हो जाए, खासकर non-technical यूजर्स के लिए।

- Human Cognitive Load: बहुत ज़्यादा या poorly presented जानकारी यूजर्स को overwhelming कर सकती है, जिससे वे AI के निर्णयों को समझने में और भी confused हो सकते हैं।

- Scalability: बड़े डेटासेट और complex मॉडल्स के लिए real-time में high-quality explanations generate करना computational रूप से महंगा हो सकता है।

- Faithfulness vs. Comprehensibility: क्या explanation वास्तव में मॉडल के आंतरिक तर्क को दर्शाती है (faithfulness), या यह सिर्फ समझने में आसान है लेकिन थोड़ा inaccurate है (comprehensibility)? इन दोनों के बीच संतुलन बनाना मुश्किल है।

-

भविष्य:

- Hybrid Approaches: भविष्य में हम ऐसे hybrid मॉडल्स देख सकते हैं जो interpretable components को non-interpretable components के साथ जोड़ते हैं, जिससे performance और interpretability दोनों को ऑप्टिमाइज़ किया जा सके।

- Human-Centric Explanations: रिसर्च इस बात पर केंद्रित है कि explanations को ऐसे तरीके से कैसे प्रस्तुत किया जाए जो यूजर्स की ज़रूरतों, पृष्ठभूमि और cognitive क्षमताओं के अनुकूल हो।

- Standardization और Evaluation: XAI क्षेत्र में explanations की quality और प्रभावशीलता का मूल्यांकन करने के लिए अधिक मजबूत metrics और frameworks की आवश्यकता है।

- Regulation और Ethics का इंटीग्रेशन: जैसे-जैसे AI regulation विकसित होगा, Model Transparency को AI डेवलपमेंट वर्कफ़्लो में और अधिक गहराई से integrate किया जाएगा।

- Interactive XAI Tools: ऐसे टूल्स का विकास होगा जो यूजर्स को explanations के साथ interact करने और अपनी ज़रूरत के अनुसार जानकारी प्राप्त करने की अनुमति देंगे।

सारांश में, Model Transparency Explainable AI (XAI) का एक मौलिक स्तंभ है, जो AI सिस्टम की आंतरिक कार्यप्रणाली को समझने योग्य बनाता है। हमने देखा कि यह न केवल AI पर trust बनाने के लिए महत्वपूर्ण है बल्कि debugging, fairness सुनिश्चित करने, regulatory compliance पूरा करने और यहाँ तक कि वैज्ञानिक खोज के लिए भी आवश्यक है। Transparency को हासिल करने के लिए intrinsically interpretable मॉडल्स और LIME, SHAP जैसे post-hoc explanation techniques दोनों का उपयोग किया जाता है, जिनमें से प्रत्येक की अपनी खूबियाँ और सीमाएँ हैं।

हालांकि, performance-interpretability trade-off, explanations की जटिलता और scalability जैसी चुनौतियाँ अभी भी बनी हुई हैं। AI के भविष्य के लिए Model Transparency अपरिहार्य है। जैसे-जैसे AI हमारे जीवन में और अधिक गहराई से प्रवेश करेगा, इसकी accountability और विश्वसनीयता सुनिश्चित करना ज़रूरी होगा। निरंतर अनुसंधान और विकास के साथ, हम उम्मीद करते हैं कि AI सिस्टम न केवल शक्तिशाली होंगे बल्कि transparent, न्यायपूर्ण और समझने योग्य भी बनेंगे, जिससे हम AI की पूरी क्षमता का जिम्मेदारी से उपयोग कर सकें और एक बेहतर, अधिक सूचित भविष्य का निर्माण कर सकें।