नमस्कार! Artificial Intelligence (AI) और Machine Learning (ML) की दुनिया में आपका स्वागत है। आज हम AI की एक बेहद ख़ास branch, Reinforcement Learning (RL) के एक fundamental concept, Markov Decision Processes (MDPs) पर बात करेंगे। AI सिर्फ़ डेटा से सीखने तक ही सीमित नहीं है; यह smart decisions लेने और challenging environments में navigate करने के बारे में भी है। RL हमें सिखाता है कि कैसे एक intelligent agent “trial and error” के ज़रिए सीखता है। इस सफ़र में, MDPs एक mathematical framework के तौर पर उभरते हैं, जो इन sequential decision-making problems को समझने और solve करने में मदद करते हैं। यह article आपको MDPs के core concepts को आसान भाषा में समझने में मदद करेगा, ताकि आप इसकी गहराई और practical applications को जान सकें।

Reinforcement Learning (RL) – सीखो और सुधारो

Reinforcement Learning Machine Learning का एक ऐसा हिस्सा है जहाँ एक “agent” एक “environment” के साथ interact करके सीखता है। इसका मुख्य उद्देश्य (goal) किसी specific task को perform करते हुए maximum “reward” earn करना होता है। आप इसे एक बच्चे के सीखने जैसा समझ सकते हैं: जब वह कुछ अच्छा करता है तो उसे इनाम (positive reinforcement) मिलता है, और ग़लती करने पर उसे कोई तकलीफ़ (penalty या negative reinforcement) होती है। इसी तरह, RL agent भी actions लेता है, environment की state बदलती है, और उसे एक reward या penalty मिलती है। agent का काम इन rewards के आधार पर अपनी strategy (जिसे policy कहते हैं) को बेहतर बनाना है ताकि वह भविष्य में ज़्यादा से ज़्यादा rewards हासिल कर सके। जैसे, एक self-driving car को रास्ता पहचानने, ट्रैफ़िक नियमों का पालन करने और सही decision लेने के लिए RL का इस्तेमाल किया जा सकता है। इसमें हर सही निर्णय पर reward और हर ग़लत निर्णय पर penalty मिलती है।

Markov Property – हर कदम नया, पर पिछला ज़रूरी नहीं

किसी भी decision-making problem को simplify करने के लिए Markov Property एक बहुत important concept है। यह कहता है कि किसी environment की next state सिर्फ़ current state और उस state में लिए गए action पर निर्भर करती है, न कि environment की पूरी पिछली history पर। आसान शब्दों में, “given the present, the future is independent of the past।” मान लीजिए आप कोई video game खेल रहे हैं; next level क्या होगा, यह इस बात पर निर्भर नहीं करता कि आपने पिछले हफ़्ते क्या खेल खेला था, बल्कि इस पर निर्भर करता है कि आप अभी किस level पर हैं और आपने अभी कौन सा action लिया है। यह property sequential decision-making problems को बहुत आसान बना देती है क्योंकि agent को हर बार पूरी history याद रखने की ज़रूरत नहीं पड़ती; उसे सिर्फ़ अपनी current situation को समझना होता है। यह concept Markov Decision Processes का आधार है, क्योंकि यह बताता है कि हम कैसे एक complex problem को manage कर सकते हैं।

Markov Decision Processes (MDPs) – Decision Making का Framework

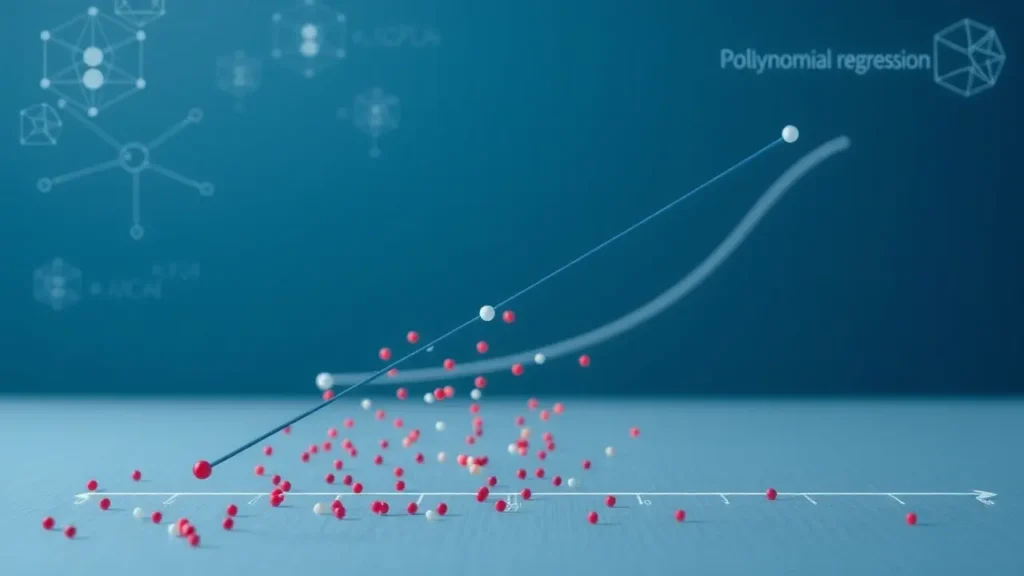

Markov Decision Process (MDP) एक mathematical framework है जिसका उपयोग sequential decision-making problems को model करने के लिए किया जाता है जहाँ outcomes stochastic (यानी random) होते हैं, और एक agent का लक्ष्य होता है कि वह समय के साथ कुल reward को अधिकतम करे। MDPs को आमतौर पर पाँच key elements से define किया जाता है, जिन्हें एक tuple (S, A, P, R, γ) के रूप में दर्शाया जाता है:

- S (States): यह सभी possible situations या positions का set है जिनमें agent हो सकता है। जैसे, एक maze में हर एक grid cell एक state हो सकती है।

- A (Actions): यह वो सभी actions हैं जो agent किसी specific state में ले सकता है। जैसे, maze में agent ‘आगे’, ‘पीछे’, ‘दाएँ’ या ‘बाएँ’ जा सकता है।

- P (Transition Probability): यह एक probability function है जो बताता है कि यदि agent state s में action a लेता है, तो वह किस probability के साथ next state s’ में जाएगा। यह stochasticity को दर्शाता है; एक ही action लेने पर भी अलग-अलग outcomes आ सकते हैं।

- R (Reward Function): यह एक फ़ंक्शन है जो agent को किसी state में action लेने या किसी new state में पहुँचने पर एक numerical reward देता है। यह reward positive या negative हो सकता है, और यही agent को बताता है कि उसका action कितना अच्छा या बुरा था।

- γ (Discount Factor): यह एक value (0 और 1 के बीच) है जो future rewards की present value को discount करती है। इसका मतलब है कि immediate rewards को future rewards से ज़्यादा weightage दिया जाता है। यह agent को short-term और long-term goals के बीच balance बनाने में मदद करता है।

MDPs का मुख्य लक्ष्य एक optimal policy खोजना है, जो यह निर्धारित करती है कि agent को हर state में कौन सा action लेना चाहिए ताकि long-term rewards को maximize किया जा सके।

MDPs में Policy और Value Functions – सही रास्ता कैसे चुनें?

एक बार जब हमने MDP को define कर दिया, तो अगला कदम यह पता लगाना है कि agent को कैसे behave करना चाहिए। इसके लिए दो महत्वपूर्ण अवधारणाएँ हैं: Policy और Value Functions।

- Policy (π): Policy एक strategy है जो हर state s के लिए यह बताती है कि agent को कौन सा action a लेना चाहिए। यह एक तरह का “rulebook” है जो agent के behaviour को define करता है। एक अच्छी policy वह होती है जो agent को सबसे ज़्यादा cumulative reward दिलाए। हमारा ultimate goal एक optimal policy (π*) खोजना है।

- Value Functions: Value function हमें यह बताती है कि कोई state या state-action pair कितना “अच्छा” है, यानी उस state से या उस state में एक particular action लेने के बाद हमें कितना expected total reward मिल सकता है।

- State-Value Function (Vπ(s)): यह बताता है कि अगर agent state s में है और policy π को follow करता है, तो उसे भविष्य में कितना expected cumulative reward मिलेगा।

- Action-Value Function (Qπ(s, a)): यह बताता है कि अगर agent state s में action a लेता है और फिर policy π को follow करता है, तो उसे कितना expected cumulative reward मिलेगा। Q-value अक्सर MDPs को solve करने में बहुत महत्वपूर्ण होती है क्योंकि यह सीधे बताती है कि किसी specific action का क्या value है।

MDPs को solve करने का मतलब है कि हम ऐसी optimal policy (π*) खोजें, जो सभी states के लिए Value Function (या Q-Function) को अधिकतम करती है। इसे प्राप्त करने के लिए कई algorithms (जैसे Value Iteration और Policy Iteration) का उपयोग किया जाता है, जो इन Value Functions को iteratively calculate करते हैं और अंततः optimal policy की ओर ले जाते हैं।

इस article में, हमने Reinforcement Learning और इसके fundamental framework, Markov Decision Processes (MDPs) की गहराई को explore किया। हमने समझा कि कैसे MDPs AI agents को dynamic environments में smart decisions लेने में मदद करते हैं, जहाँ stochasticity और sequential outcomes महत्वपूर्ण होते हैं। हमने Markov Property के महत्व को देखा, जो जटिल problems को simplify करता है, और MDPs के core elements – States (S), Actions (A), Transition Probabilities (P), Reward Function (R), और Discount Factor (γ) – को विस्तार से जाना। आख़िर में, हमने Policy और Value Functions की अवधारणाओं पर चर्चा की, जो MDPs को solve करने और optimal strategies को डिज़ाइन करने के लिए essential हैं। MDPs AI, robotics, autonomous systems, गेमिंग और ऑपरेशनल रिसर्च जैसे कई क्षेत्रों में एक powerful tool साबित हुए हैं, जो हमें अनिश्चितता के माहौल में intelligent behaviour बनाने में सक्षम बनाते हैं। इस framework को समझकर, हम AI की दुनिया में और भी ज़्यादा innovative solutions develop कर सकते हैं।